Covid-19 : la réponse des plateformes en ligne face à l'ultradroite

Présentation de Tech Against Terrorism

Introduction

Une montée des théories du complot et de la désinformation au profit des extrémistes

Derrière l’opportunisme, la menace de l’accélérationnisme

Des bavardages en ligne aux actions dans le monde réel

La réponse des plateformes en ligne et l’avenir de la modération de contenu

Un impact durable sur les libertés fondamentales

Commentaires sur la loi Avia, visant à lutter contre les contenus haineux sur internet

Recommandations

Résumé

Les terroristes et les extrémistes sont avant tout des manipulateurs qui cherchent à exploiter les facteurs de stress présents dans nos sociétés. La pandémie de Covid-19, les mesures de confinement qui en ont découlé ainsi que la propagation de la mésinformation et de la désinformation en ligne qui y sont liées sont donc des conditions idéales à exploiter pour certains acteurs malveillants. Les partisans de l’ultradroite, en particulier, ont rapidement saisi l’occasion offerte par la crise du Covid-19 pour ancrer leurs idées dans le débat public et recruter de nouveaux membres. Bien qu’elle se manifeste principalement en ligne, cette exploitation ne s’est pas limitée à la sphère virtuelle et s’est matérialisée dans des événements réels, par exemple lorsque des extrémistes violents se sont mêlés aux protestations contre le confinement et les restrictions sanitaires et que des plans d’attaques terroristes ont été contrecarrés.

Alors que le secteur technologique a rapidement réagi à la vague de désinformation, les changements rapidement apportés aux politiques de modération des contenus en ligne ont déjà des conséquences importantes pour l’avenir de la modération de contenus et de la liberté d’expression en ligne. En effet, le secteur technologique mondial, notamment les réseaux sociaux et les plateformes d’hébergement de contenus, a réagi particulièrement rapidement à la propagation des théories de désinformation et de conspiration liées au Covid-19. Dans cette note, Tech Against Terrorism analyse comment les partisans de l’ultradroite ont exploité l’instabilité causée par la pandémie de Covid-19, et ce que la réponse du secteur technologique signifie pour la liberté d’expression en ligne et la responsabilité des plateformes.

Maygane Janin,

Analyste à Tech Against Terrorism.

Ses recherches portent sur le terrorisme d’extrême droite et l’extrémisme violent, ainsi que sur l’utilisation d’Internet à des fins de financement du terrorisme.

Flora Deverell,

Analyste à Tech Against Terrorism.

Ses recherches portent sur les réglementations techniques et les droits numériques. Elle a depuis quitté Tech Against Terrorism pour poursuivre sa formation en droit.

Les géants du numérique (1) : magnats de la finance

Les géants du numérique (2) : un frein à l'innovation ?

Vers la souveraineté numérique

La blockchain, ou la confiance distribuée

2022 le risque populiste en France

2022, le risque populiste en France (vagues 2 et 3)

Covid-19, États-Unis, Chine, Russie : les grandes puissances inquiètent l'opinion

Les attentats islamistes dans le monde 1979-2019

Présentation de Tech Against Terrorism

Un site de pasting est un site où l’on peut partager du contenu en l’écrivant ou en le « collant » dans une zone de texte, à la suite de quoi est créée une URL partageable.

« La FinTech, contraction de Financial Technology (technologie financière) désigne des petites entreprises (start-up et PME) qui fournissent des services financiers grâce à des solutions innovantes. Les domaines d’application sont variés : paiement mobile, financement participatif (crowdfunding), gestion de l’épargne, assurance et crédit, conseil financier en ligne, aide à la décision grâce aux algorithmes… » (Ministère de l’Économie, des Finances et de la Relance, « La Fintech, le numérique au service du secteur financier », Bercy infos, 19 janvier 2019.

Voir Tech Against Terrorism, « Press release: 10th April 2010 – Launching an updated version of Jihadology to limit terrorist exploitation of the site », techagainstterrorism.org, 10 avril 2019.

Voir Tech Against Terrorism, « Press release: Tech Against Terrorism awarded grant by the Government of Canada to build Terrorist Content Analytics Platform », techagainstterrorism.org, 26 juin 2019.

Tech Against Terrorism est un partenariat public-privé soutenu par la direction exécutive du Comité contre le terrorisme des Nations unies (UN CTED). Tech Against Terrorism a été lancé en avril 2017 au siège des Nations Unies, à New York, et a depuis été mis en œuvre par la Fondation Quantspark. Il s’agit d’une initiative public-privé financée à la fois par l’industrie technologique via le Global Internet Forum to Counter Terrorism (GIFCT) et par différents gouvernements. À ce jour, les gouvernements de l’Espagne, de la République de Corée, de la Suisse et du Canada ont apporté leur soutien financier à Tech Against Terrorism.

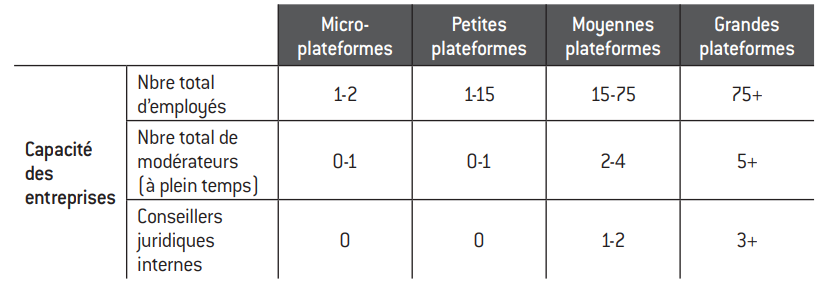

L’objectif principal de Tech Against Terrorism est de soutenir l’industrie technologique dans le renforcement de ses capacités à lutter contre l’utilisation d’Internet à des fins terroristes tout en respectant les droits humains. Tech Against Terrorism travaille avec tous les types d’entreprises technologiques, tels que les réseaux sociaux, les sites dit de pasting *, les plateformes de stockage de fichiers, les messageries en ligne ou encore les plateformes Fintech ** et les fournisseurs d’infrastructures Web. Notre mission principale consiste à fournir à l’industrie technologique mondiale les outils nécessaires pour lutter efficacement contre les activités terroristes sur leurs plateformes. Pour ce faire, nous travaillons sur trois axes :

1. L’analyse de la menace et la sensibilisation. Nous effectuons une analyse approfondie des renseignements open source (toute donnée publiquement accessible) afin d’identifier les plateformes à risque et d’établir des relations de travail constructives avec le secteur technologique, et de faciliter la coopération entre les secteurs public et privé ;

2. Le partage des connaissances et des meilleures pratiques. Nous facilitons les mécanismes de soutien intra-industriels et intersectoriels grâce à des outils en ligne, au partage de bonnes pratiques mises en place par les chefs de file du secteur, des manuels et à des formations pratiques pour soutenir les décisions de modération des politiques et à des contenus. Nous travaillons en étroite collaboration avec le GIFCT pour organiser des ateliers et des séminaires en ligne à l’échelle mondiale. Nous soutenons également les entreprises par le biais de nos programmes d’adhésion à l’initiative Tech Against Terrorism et de mentorat pour le GIFCT ;

3. Le développement technologique et le soutien opérationnel. Nous fournissons un soutien technique et des ressources aux entreprises technologiques afin d’améliorer leurs mécanismes de lutte contre le terrorisme, notamment par le biais de l’analyse de données et du soutien au développement de solutions technologiques. Parmi les exemples de précédents projets dans ce domaine, on peut citer notre travail avec Jihadology.net *** et notre travail actuel sur la plateforme d’analyse de contenu terroriste (Terrorist Content Analytics Platform, ou TCAP) ****.

Tech Against Terrorism se compose d’une équipe interdisciplinaire d’experts du contre-terrorisme, d’analystes de renseignements open source, de développeurs et d’analystes de données. La composition de notre équipe nous permet d’apporter un soutien complet à l’industrie technologique mondiale d’une manière efficace, précise et conforme aux droits humains.

Introduction

Sur ce thème, voir Anne Muxel, De la distanciation sociale à la distanciation intime, Fondation pour l’innovation politique, juin 2020.

Dans cette étude, nous utilisons le terme « ultradroite » pour désigner les mouvances issues de l’idéologie de l’extrême droite ayant recours à la violence à des fins politiques.

Voir Les attentats islamistes dans le monde 1979-2019, Fondation pour l’innovation politique, novembre 2019.

Pour plus d’informations sur l’exploitation de la pandémie par les groupes terroristes islamistes, voir Julie Coleman, « Les sables mouvants du paysage terroriste sahélien », icct.nl, 16 mars 2020, et Valerio Mazzoni, « Coronavirus: how Islamist militants are reacting to the outbreak », eeradicalization.com, 30 mars 2020.

Pour l’Organisation mondiale de la santé (OMS), une infodémie désigne le phénomène de désinformation « qui se propage plus vite et plus facilement que le virus ». Voir United Nations Department of Global Communications (DGC), « UN tackles ‘infodemic’ of misinformation and cybercrime in Covid-19 crisis », un.org, 31 mars 2020.

Voir Ashton Kingdon, « The gift of the GAB: the utilisation of Covid-19 for Neo-Nazi Recruitment », gnet-research.org, 7 mai 2020.

Internet et les plateformes en ligne qui le composent constituent un élément crucial de notre tissu social depuis un certain temps déjà, mais ils sont devenus un élément encore plus central dans le cadre de la réponse mondiale à l’épidémie de Covid-19. Alors que le monde s’est refermé sur lui-même, nous avons vu des personnalités politiques et des organisations internationales communiquer avec le public par le biais des réseaux sociaux et des plateformes de messagerie. Nous avons vu des amis et des familles séparés s’appuyer davantage sur les communications en ligne pour rester connectés 1. Nous avons également vu des étudiants et des travailleurs être supervisés et coordonnés par le biais de plateformes en ligne. Cependant, nous avons également constaté l’évolution et la fragmentation de notre environnement d’information, notamment une augmentation du contenu en ligne présentant des chevauchements évidents avec des messages portés par l’ultradroite 2. Ainsi Internet, tout en connectant les gens dans une période de distanciation sociale, est devenu le reflet des divisions et des antagonismes de nos sociétés, les terroristes et les extrémistes l’utilisant pour propulser leurs idéologies.

D’une certaine manière, les terroristes et les extrémistes peuvent être considérés comme des manipulateurs, exploitant les griefs et les facteurs de stress préexistants dans les sociétés et chez les individus, tels que les lacunes gouvernementales ou les quêtes individuelles d’identité et de réponse. Dans ce contexte, il n’est pas surprenant que la pandémie de Covid-19, les mesures de confinement, les restrictions, l’instabilité économique et l’anxiété générale qui en ont découlé aient été des facteurs de stress idéaux à exploiter pour les terroristes et les extrémistes. Les failles en matière de crédibilité causées par la réaction hésitante de certains gouvernements face au virus et par le flux de mésinformation et de désinformation en ligne ont en outre constitué une brèche, à la fois dans les récits conventionnels et dans la confiance dans les gouvernements, dont les acteurs malveillants pouvaient tirer avantage. Les groupes terroristes islamistes avec une présence sur le terrain – tels que l’État islamique, Al-Qaida et Al-Shabaab 3 – tentent ainsi de tirer profit de la déstabilisation accrue des gouvernements locaux fragilisés par la crise (notamment en matière de santé et de sécurité) pour se présenter comme une solution viable et étendre leur contrôle sur le terrain 4.

Pendant ce temps, dans les pays occidentaux, les militants de l’ultradroite exploitent cette « infodémie Covid-19 5 » pour pénétrer le discours public et distiller leurs idéologies à un public plus large.

Étant donné que l’exploitation de la crise de Covid-19 par l’ultradroite s’est faite principalement en ligne, contrairement aux terroristes islamistes, nous avons décidé de nous concentrer, pour cette étude, sur la manipulation en ligne de la pandémie par les militants violents de l’extrême droite. En effet, il y a eu une augmentation importante des idées et de la propagande de l’ultradroite autour du virus dans les discussions sur Internet 6, et ce même en dehors des cercles extrémistes. Cette pénétration dans les discussions publiques a été facilitée par un croisement entre les idéologies extrémistes et les discussions communes au grand public. Cette manipulation du contexte pandémique représente donc un exemple intéressant de la distorsion du paysage de l’information par les extrémistes violents et, ce faisant, de leur utilisation des plateformes en ligne.

Dans la présente note, nous analyserons tout d’abord la manipulation du discours sur la pandémie par les militants de l’ultradroite. Puis, dans un deuxième temps, nous évaluerons les implications pour l’avenir de la modération du contenu en ligne à travers le prisme des réponses actuelles du secteur technologique face à la vague de désinformation et de théories complotistes. Enfin, nous avons inclus le commentaire de Tech Against Terrorism sur la législation française de lutte contre la haine sur Internet (ou loi Avia). En effet, cette proposition de loi et sa censure par le Conseil constitutionnel français le 18 juin 2020 abordent certains des débats les plus importants concernant la réglementation en ligne dans le monde démocratique.

« A key difference between the radical/populist right and the extreme-right is their willingness to use extra-state violence against political opponents and ‘racial’ enemies. The extreme-right embrace violence (whether fantasies of expanded state violence should they come to power, and terroristic, individual violence in the here and now) in order to promote an ideological agenda and this ideological agenda is, typically, a variation of fascism or neo-Nazism » (John Richardson et Matthias Wasser, « The symbols and ideas of the radical right: why their opponents should be more informed », connectfutures.org, 26 mai 2020.

Voir Ben Makuch, « Neo-Nazi Terror Group Atomwaffen Division Re-Emerges Under New Name », vice.com, 5 août 2020.

| Qu’est-ce que l’ultradroite ?

Le qualificatif d’extrémisme violent, ou de terrorisme d’extrême droite, d’ultradroite, de droite radicale ou d’extrémisme à motivation ethnique et raciale… regroupe une variété d’idéologies et de réseaux différents, comprenant principalement le néonazisme, le suprémacisme blanc, le nationalisme blanc et le nationalisme culturel. Ils sont qualifiés d’« extrême droite » ou de « droite radicale » car ils partagent un certain nombre de caractéristiques idéologiques, notamment – mais pas uniquement – le racisme, l’ultranationalisme, l’ethnocentrisme, l’antisémitisme, l’opposition à l’égalité et aux principes démocratiques avec l’extrême droite dite mainstream. Cependant, il existe des différences importantes entre l’extrême droite mainstream et l’extrême droite violente, le principal contraste étant le recours à la violence : « Une différence essentielle entre la droite populiste et l’ultradroite est leur volonté de recourir à la violence extra-étatique contre les opposants politiques et les ennemis “raciaux”. L’ultradroite recourt à la violence (qu’il s’agisse de fantasmes de violence étatique accrue si elle venait à prendre le pouvoir, ou de violence terroriste individuelle ici et maintenant) afin de promouvoir un programme idéologique. Ce programme idéologique est généralement une variante du fascisme ou du néonazisme *. » Nous utilisons dans cette étude le terme « ultradroite » pour désigner ces mouvances issues de l’idéologie de l’extrême droite et ayant recours à la violence à des fins politiques. En comparaison avec le terrorisme islamiste, le paysage de l’ultradroite représente un mouvement moins structuré, plus décentralisé et fragmenté, avec une multitude de groupes et de réseaux différents – dont certains existent principalement en ligne. Parmi les groupes et mouvements les plus influents, on peut citer :

|

Cette chronologie ne comprend que les attentats qui ont fait au moins 10 morts. D’autres attaques motivées par des idéologies d’extrême droite ont eu lieu depuis 2011, notamment l’attaque de la synagogue de Halle, en Allemagne, qui a fait 2 morts, et la fusillade de la synagogue de Poway, aux États-Unis, qui a fait 1 mort, toutes deux en 2019.

| Chronologie des récentes attaques terroristes et extrémistes de droite violente *

2011. Attaques d’Oslo et d’Utøya, en Norvège, 77 morts. |

Une montée des théories du complot et de la désinformation au profit des extrémistes

Selon l’Ethical Journalism Network, la mésinformation et la désinformation désignent toutes deux des informations fausses. La différence essentielle entre les deux est que la désinformation est « créée délibérément pour nuire à une personne, un groupe social, une organisation ou un pays », alors que la mésinformation ne l’est pas. Les deux peuvent être utilisées – et, dans le cas de la désinformation, sont créées – par des terroristes et des extrémistes violents pour manipuler le paysage de l’information à leurs propres fins. Nous nous concentrerons ici sur l’utilisation de la désinformation et l’exploitation des théories du complot. Voir « “Fake News” | Deep Fakes | Information Disorder | Disinformation | Misinformation | Mal-information », ethicaljournalismnetwork.org, s.d.

Pour un référencement plus complet des théories du complot autour du Covid-19, voir Marc-André Argentino et Amarnath Amarasingam, « The Covid Conspiracy Files », gnet-research.org, 8 avril 2020.

Alors que l’épidémie de Covid-19 a contraint le monde au confinement, l’espace virtuel a connu une recrudescence des théories du complot, de la mésinformation et de la désinformation 7 sur l’origine et la prolifération du virus ainsi que sur les réactions des gouvernements à ce sujet. Bien qu’en général les théories du complot existent le plus ouvertement et avec le plus de ferveur aux marges d’Internet, celles liées au Covid-19 ont rapidement trouvé leur place sur les plateformes classiques, en particulier les réseaux sociaux. Parmi les principales théories du complot liées au Covid-19, qui ne sont pas le monopole de l’extrême droite et que l’on voit également évoluer dans les réseaux d’extrême gauche, par exemple, on trouve un certain nombre de souches idéologiques 8.

La 5G, qui succède à la 4G, est le réseau qui fournit la connectivité pour l’utilisation des téléphones portables.

Sur la circulation de messages conspirationnistes, y compris ceux qui parlent de la technologie 5G, dans des groupes de discussions français sur Twitter et Facebook, voir Iris Boyer et Théophile Lenoir, Information Manipulations Around Covid-19: France Under Attack, Institut Montaigne/Institute for Strategic Dialogue (ISD), juillet 2020.

Voir « Qui sont les « anti 5G » qui se mobilisent sur le web ? », franceinter.fr, 29 septembre 2020.

« The end goal [of the virus] is to impose social restrictions, and force vaccinations » (Marc-André Argentino et Amarnath Amarasingam, art. cit.).

Marc-André Argentino, « QAnon conspiracy theory about the coronavirus pandemic are a public health threat », theconversation.com, 8 avril 2020.

Voir ISD and BBC Click investigation, « Far-right exploitation of Covid-19 », Covid-19 Disinformation briefing n° 3, 12 mai 2020.

Voir Marc-André Argentino, art. cit.

Ibid.

Voir « White Supremacists Embrace “Accelerationism” », adl.org, 14 avril 2019.

La 5G et l’anti-gouvernement

Parmi les plus populaires, cette théorie est centrée sur l’idée selon laquelle la Chine aurait provoqué la pandémie par le biais de la 5G 9 et sur le fait que les mesures de confinement et les restrictions demandées par les gouvernements viseraient à restreindre la liberté des personnes 10. En France, des chercheurs ont observé une explosion du discours anti-5G sur les réseaux sociaux avec l’apparition du coronavirus et souligné une importante porosité entre les différentes théories du complot 11.

Le contrôle social

L’idée directrice est ici que « l’objectif final [du virus] est d’imposer des restrictions sociales et de forcer les vaccinations 12 » afin de pouvoir surveiller et suivre la population.

L’arme biologique

Il s’agit d’une croyance populaire au sein de l’extrême droite selon laquelle le Covid-19 serait un virus créé par l’être humain qui cible les personnes en fonction de leur race et qui a été libéré intentionnellement ou accidentellement.

QAnon et la théorie du Deep State (« État dans l’État »)

Apparus en 2017, QAnon et les théories connexes du Deep State ont été parmi les plus prolifiques pendant la pandémie de Covid-19 13, gagnant de plus en plus de terrain sur les plateformes en ligne et attirant de nouveaux publics. Ces théories englobent des récits différents et changeants sur le virus, faisant de la pandémie tantôt un complot pour nuire à la réputation du président Trump, tantôt une dissimulation orchestrée pour que celui-ci puisse arrêter des agents du Deep State ou encore un « combat spirituel », tout en s’appuyant sur une rhétorique antigouvernementale et xénophobe 14. L’analyse de la présence de QAnon sur les réseaux sociaux souligne la capacité du mouvement à exploiter la pandémie, en particulier en utilisant des comptes publics sur les réseaux sociaux pour atteindre des publics plus larges et nouveaux. Les partisans de QAnon ont notamment utilisé des groupes publics discutant de la pandémie sur Facebook pour attirer de nouvelles audiences vers leurs propres sites Web. Ce faisant, ils ont réussi à rassembler 80 millions d’interactions sur Facebook, entre janvier et avril 2020, un volume alarmant par rapport aux 6,2 millions d’interactions pour les messages liés à l’Organisation mondiale de la santé (OMS) au cours de la même période 15. En seulement trois mois, le nombre de hashtags QAnon sur Twitter a augmenté de 21% 16.

Les théories du chaos

Théories comprenant l’idée que les instabilités créées par la pandémie devraient être renforcées pour provoquer un chaos et des changements sociétaux ; ces théories sont similaires à l’idée d’accélérationnisme 17 populaire parmi les militants de l’ultradroite. L’accélérationnisme fait référence à l’effondrement accéléré de la société telle que nous la connaissons par des moyens violents – comme le terrorisme et la guérilla – et par des moyens non violents comme la manipulation politique et médiatique pour accroître les tensions existantes du système et polariser davantage la société.

« A global elite of power brokers hell bent on enriching themselves and maintaining their Satanic child- murdering sex cult » (« QAnon », adl.org, s.d.).

En avril 2019, une milice d’extrême droite promouvant les théories conspirationnistes QAnon a menacé à l’arme à feu 300 migrants à la frontière entre les États-Unis et le Mexique. Un an auparavant, le 16 juin 2018, un partisan QAnon avait plaidé coupable de charges terroristes pour avoir bloqué le barrage Hoover au Nevada avec un véhicule blindé dans lequel on a retrouvé une arme et 900 cartouches de munitions. Voir « QAnon », art.cit.

Voir Ben Collins, « Local FBI field office warns of « conspiracy theory-driven domestic extremists » », nbcnews.com, 1er août 2019.

Récemment, une théorie conspirationniste liée à QAnon concernant la boutique en ligne Wayfair et le trafic sexuel d’enfants a fait son chemin sur le Twitter français. Voir William Audureau, « Comment le site de commerce Wayfair s’est retrouvé accusé d’organiser un réseau pédophile », lemonde.fr, 16 juillet 2020.

Voir Justin Ling, « QAnon’s Madness Is Turning Canadians Into Potential Assassins », foreignpolicy.com, 13 juillet 2020.

Pour plus d’informations sur les politiques de ces différentes plateformes concernant les contenus liés à QAnon, voir : pour Twitter, « Facebook et Twitter bannissent des milliers de comptes de la mouvance conspirationniste QAnon », Nouvel Obs, 20 août 2020 ; pour YouTube, l’équipe YouTube, « Managing harmful conspiracy theories on YouTube », 15 octobre 2020 et « YouTube s’en prend à son tour à la mouvance conspirationniste QAnon », lemonde.fr, 15 octobre 2020 ; pour Etsy, Megan Farokhmanesh, « Etsy is banning QAnon merch », The Verge, 7 octobre 2020 ; for TikTok, Kim Lyons, « TikTok removing accounts of users who share QAnon-related content », The Verge, 19 Octobre 2020 et Alex Hern, « TikTok expands hate speech ban », The Guardian, 21 octobre 2020 ; pour Facebook, « An Update to How We Address Movements and Organizations Tied to Violence », Facebook, 27 octobre 2020.

| Le mouvement QAnon

QAnon est apparu en 2017 sur 4chan, un forum fondé sur le partage d’images populaire parmi les réseaux en ligne d’ultradroite, et basé sur des éléments antigouvernementaux, antisémites et xénophobes. Le nom « QAnon » est dérivé du pseudonyme de l’utilisateur de 4chan à l’origine du mouvement, « Q Clearance Patriot » (la lettre Q signifiant une habilitation au secret-défense aux États-Unis), alertant dans une série de posts d’un complot au sein du gouvernement visant à affaiblir la présidence de Donald Trump. Les partisans de QAnon ont une grande méfiance envers les gouvernements et croient en un État dans l’État (Deep State), en une élite mondiale de « gens de pouvoir déterminés à s’enrichir et à maintenir leur culte sexuel satanique de meurtriers d’enfants *. » Bien que QAnon ne soit pas un mouvement conspirationniste animé par des extrémistes violents, il est basé sur des éléments rhétoriques que l’on trouve couramment dans ces milieux et a conduit à des actes violents aux États-Unis **. La montée de la violence liée à QAnon a même conduit le FBI à mettre en garde contre les risques d’actes de terrorisme domestique motivés par des théories du complot ***. QAnon est particulièrement intéressant comme étude de cas sur la façon dont la rhétorique d’extrême droite peut s’infiltrer dans l’univers mainstream et motiver des attaques en dehors du monde virtuel. En effet, le mouvement conspirationniste et ses partisans sont passés de 4chan, une plateforme plutôt marginale, à des médias sociaux grand public (y compris Facebook, Twitter et Youtube), élargissant à chaque fois leur audience. Le cas de QAnon révèle également comment les théories du complot peuvent devenir influentes au-delà des frontières nationales, soit par le biais de théories du complot directement liées à cette mouvance, occasionnellement diffusées internationalement et dans différentes langues ****, soit par le fait que le mouvement QAnon en tant que tel gagne du terrain en dehors des États-Unis, comme cela a notamment été le cas au Canada récemment *****. Un certain nombre de grandes plateformes en ligne ont récemment pris des mesures contre la diffusion de contenus liés à QAnon sur leurs plateformes, le plus souvent sur la base de la lutte contre la désinformation ou contre les menaces de violence dans le monde physique. Twitter a été l’une des premières à le faire, à la mi-juillet, en bannissant des milliers de comptes. Pour tenter de répondre aux défis « fluctuants et évolutifs [shifting and evolving] » de la modération de contenu, YouTube a quant à elle élargi sa politique en la matière pour interdire les théories conspirationnistes « qui ont été mobilisées pour justifier des actes de violence dans le monde physique [that have been used to justify real-world violence] ». Ce faisant, la plateforme a encore étendu sa politique sur la désinformation et les théories conspirationnistes nuisibles. Conformément à ses lignes directrices préexistantes, la plateforme de e-commerce Etsy a retiré de son site les marchandises liées à QAnon au motif que ces articles « encouragent la haine, incitent à la violence, ou promeuvent ou approuvent une désinformation nuisible [promote hate, incite violence, or promote or endorse harmful misinformation] ». La plateforme a également retiré des articles liés au groupe suprémaciste blanc Proud Boys pour le même motif. TikTok a également pris des mesures contre le mouvement QAnon, en supprimant des comptes partageant des contenus qui y sont liés, au motif que ceux-ci violent sa politique de lutte contre la désinformation. Quelques jours après, la plateforme a renforcé sa politique contre les discours haineux afin que celle-ci cible les idéologies « voisines » du néonazisme et du suprémacisme blanc (y compris le nationalisme blanc et la théorie du génocide blanc). Ce faisant, elle visait également à cibler « la diffusion d’un langage codé et de symboles susceptibles de normaliser les discours et les comportements haineux [the spread of coded language and symbols that can normalise hateful speech and behaviour] ». Enfin, Facebook a récemment modifié ses directives communautaires afin de limiter la capacité d’organisation des groupes qui n’appellent pas directement à la violence, mais dont la rhétorique témoigne d’un soutien à l’usage de la violence. En plus de supprimer le contenu QAnon et les réseaux qui soutiennent le recours à la violence, Facebook a également commencé à mettre en œuvre un programme de « redirection », en partenariat avec le Global Network on Extremism and Technology (GNET, la branche recherche du GIFCT et l’un des partenaires principaux de TAT). Les utilisateurs qui recherchent des termes liés à QAnon sur Facebook et Instagram sont désormais redirigés vers des sources fiables issues du GNET. Dans l’ensemble, la riposte des plateformes en ligne***** contre QAnon démontre un changement de politique de modération de contenu. Celle-ci couvre désormais les contenus en ligne, les groupes n’appelant pas directement à la violence mais dont la rhétorique exprime un soutien au recours à la violence, ainsi que les groupes qui présentent un risque important d’actes de violence hors ligne. Ce faisant, les plateformes ciblent directement des groupes sur la base d’une évaluation des préjudices et des risques de violence dans le monde physique. |

Ces théories du complot et ces mésinformations peuvent donc se retrouver dans divers cercles politiques, mais l’ultradroite reste néanmoins unique par la manipulaton qu’elle tente d’opérer afin de servir ses propres fins.

« A global plot to subjugate humanity » (Alexander Meleagrou-Hitchens et Blyth Crawford, « 5G and the Far Right: How Extremists Capitalise on Coronavirus Conspiracies », gnet-research.org, 21 avril 2020).

« We don’t need to convince the masses of our ideas. The pandemic has already done that… Whites panic bought guns, food, water, and prepare for social unrest all on their own » (cité in Angie Gad, « The Coronavirus Isn’t Immune From the Far-Right », gnet-research.org, 28 mai 2020).

« We found that many of the 5G conspiracy groups we analysed are not openly far right, but they appear to be run by known extremist Telegram users who dress them up as sources of information for those seeking answers » (Alexander Meleagrou-Hitchens et Blyth Crawford, cit.).

Ces théories du complot se sont rapidement retrouvées dans le discours dominant sur le virus, se propageant de manière virale sur les réseaux sociaux et les applications de messagerie, atteignant des individus cherchant des réponses à leurs questions sur la pandémie. Bien qu’elles ne soient pas créées par des extrémistes, ni spécifiques à l’un ou l’autre côté du spectre politique 18, ces théories du complot présentent toutefois d’importantes similitudes avec les discours de l’ultradroite et partagent des principes qui prolifèrent généralement dans ces milieux. En effet, souvent fondées sur l’idée d’un « complot mondial visant à assujettir l’humanité 19 » et sur une rhétorique antigouvernementale, ces théories conspirationnistes sont pour la plupart de nature raciste, xénophobe et antisémite. Lorsque le « virus créé à l’étranger » est devenu un sujet de discussion récurrent en ligne par le biais des théories du complot, les extrémistes y ont vu une occasion d’exploiter davantage les idées qui constituent la base de leur propre rhétorique.

Grâce aux idées présentées dans les théories conspirationnistes liées au Covid-19, ils ont trouvé un moyen d’instiller leurs messages dans le discours public. Cette convergence des idées est d’autant plus visible pour certaines théories du complot qui sont directement liées à l’extrême droite, notamment les théories du Deep State (QAnon), ou celles de nature apocalyptique prônant le chaos social. L’un des messages d’un partisan de l’extrême droite sur Telegram (une application de messagerie instantanée) illustre particulièrement comment la pandémie et l’instabilité qui en résulte profitent aux extrémistes : « Nous n’avons pas besoin de convaincre les masses de nos idées. La pandémie l’a déjà fait… Les Blancs paniqués ont acheté des armes, de la nourriture, de l’eau, et se préparent d’eux-mêmes à l’agitation sociale 20. »

Pour les groupes violents, il s’agissait alors simplement de se fondre dans le débat général et de tirer profit de l’opportunité offerte par la pandémie. Les militants de l’ultradroite se sont donc massivement dirigés vers les plateformes en ligne pour propager de la désinformation et des théories du complot, ainsi que leurs propres messages haineux. Leur succès réside dans le fait qu’ils ne se présentent pas ouvertement comme étant des extrémistes, mais qu’ils infiltrent plutôt des discussions en ligne avec lesquelles ils partagent des éléments de rhétorique et en postant des liens vers des sites Web plus marginaux qu’ils administrent. Une étude a révélé que certains des groupes complotistes sur Telegram étaient gérés par « des utilisateurs extrémistes connus de Telegram qui déguisent [ces groupes] en sources d’information destinées aux internautes en quête de réponses 21 ».

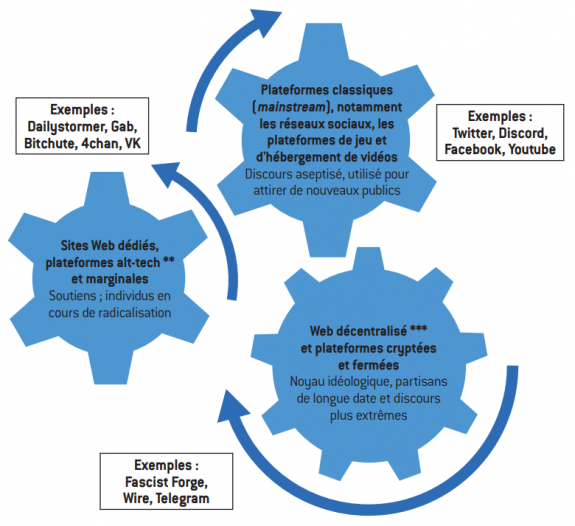

Il convient de noter que ce résumé est simplifié afin de donner un aperçu de l’environnement en ligne des extrémistes violents dans le monde occidental. Certaines des plateformes mentionnées dans ce schéma peuvent être considérées comme à cheval entre plusieurs des catégories proposées ici. Pour en savoir plus sur la manière dont les terroristes et les extrémistes violents utilisent Internet, voir le site de Tech Against Terrorism ainsi que sa série de podcasts.

Le terme « alt-tech » fait référence à un écosystème en ligne alternatif qui a émergé en réponse à la modération accrue des contenus violents en ligne et à la suppression de comptes appartenant à des militants violents. Cette sorte d’écosystème en ligne est cloné sur le système des plateformes traditionnelles et les imite donc dans leurs objectifs (réseaux sociaux, partage de contenu, hébergement vidéo) tout en se présentant comme une alternative prônant la « libre expression » face à la modération des plateformes traditionnelles. L’utilisation des plateformes alt-tech ne se limite pas à l’ultradroite, bien que certaines plateformes soient des plaques tournantes pour ce type d’extrémisme. Voir Megan Squire, « Can Alt-Tech Help the Far Right Build an Alternate Internet », fairobserver.com, 23 juillet 2019.

Au sujet du Web décentralisé, voir Zoe Corbyn, « Decentralisation: the next big step for the world wide web », theguardian.com, 8 septembre 2018, et Tech Against Terrorism, « Analysis: ISIS use of smaller platforms and the DWeb to share terrorist content – April 2019 », techagainstterrorism.org, avril 2019.

L’utilisation d’Internet par les terroristes et les extrémistes violents est un phénomène multiforme et de grande ampleur, exploitant l’écosystème technologique dans son ensemble à des fins de propagande, de recrutement, de financement et d’organisation. L’utilisation de plateformes en ligne à des fins de propagande et de discussion peut être schématisée comme suit*. En progressant à travers les différentes catégories de plateformes , des moins connues aux plus importantes, les terroristes et les extrémistes exploitent le paysage en ligne pour se faire connaître davantage et propager leurs idéologies haineuses.

L’environnement virtuel de l’ultradroite

Source : Tech Againt Terrorism ; Fondation pour l’innovation politique.

Voir Cynthia Miller-Idriss, « The risks of online radicalization in the Covid-19 era », radicalrightanalysis.com, 26 avril 2020.

« This dynamic creates a perfect storm for extremist recruitment and Extreme isolation and increased online presence on gaming platforms, social media, and more creates growing possibilities for exposure to extremist content and expands the gateways that can lead to extremist radicalizations » (ibid.).

Ainsi, les militants de l’ultradroite ont essayé d’élargir leur audience à de nouveaux publics et d’ancrer leurs idées dans le débat public. Dès les premières mesures de confinement, les gouvernements et les experts ont exprimé leurs inquiétudes sur le risque que la hausse des difficultés sociales et économiques, associée à une augmentation du temps passé en ligne, contribue à des processus de radicalisation, notamment chez les jeunes confinés chez eux et à qui on interdit les activités récréatives et culturelles à l’extérieur 22. Le fait que les interactions en ligne puissent jouer un rôle important dans la radicalisation d’un individu est reconnu par les experts en contre-terrorisme depuis un certain temps déjà. Toutefois, la particularité de la pandémie de Covid-19 à cet égard est qu’elle a entraîné une augmentation sans précédent de l’activité en ligne, en particulier chez les jeunes. Un phénomène résumé par la chercheuse Cynthia Miller-Idriss : « Cette dynamique crée les conditions parfaites pour le recrutement et la radicalisation extrémistes. L’isolement extrême et la présence accrue en ligne sur les plateformes de jeux vidéo, sur les réseaux sociaux et autres multiplient les possibilités d’exposition à des contenus extrémistes et les passerelles qui peuvent conduire à des formes de radicalisation 23. »

Les terroristes et les extrémistes tirent profit des sentiments d’insécurité, d’injustice et de protestation en se posant comme la solution aux difficultés rencontrées dans la vie, par exemple les besoins économiques, le besoin d’appartenance, les sentiments d’anxiété ou de désillusion vis-à-vis de la société. Or la pandémie crée un terrain parfaitement propice à l’anxiété et au besoin d’explications qui se combinent avec l’augmentation du temps passé en ligne. Les extrémistes intensifient alors leurs efforts de propagande et se présentent comme la solution évidente à une période d’instabilité et d’insécurité sans précédent.

Le « zoom-bombing » est une expression dérivée de l’anglais « photo-bombing », peu à peu entrée dans la culture populaire française et décrivant l’action d’apparaître devant ou derrière une personne à son insu tout en faisant une plaisanterie alors que celle-ci est en train d’être prise en photo.

L’action de « troller » consiste à polluer les forums des réseaux sociaux en déclenchant des querelles, en s’opposant aux personnes présentes ou en publiant des messages agressifs ou hors sujet.

« Users have reported Zoom-bombers shouting racial slurs, drawing neo-Nazi insignia, sharing explicit or violent videos and « doxxing » – sharing the confidential personal information of – faculty and participants » (Simon Purdue, « Zoom-bombing and the far-right latest assault on college communities », radicalrightanalysis.com, 19 avril 2020).

FBI Boston, « FBI Warns of Teleconferencing and Online Classroom Hijacking During Covid-19 Pandemic », fbi.gov, 30 mars 2020.

| Les efforts de perturbation des extrémistes en ligne : la tendance du « zoom-bombing » *

Pour les militants de l’ultradroite, les campus universitaires américains sont depuis un certain temps une cible de recrutement privilégiée ; ils inondent certains campus avec leurs tracts de propagande et perturbent les activités qui y ont lieu. Avec la fermeture des universités et le déplacement des cours, du monde physique vers le virtuel, les extrémistes ont suivi cette migration et ont commencé à pratiquer le « zoom-bombing » sur les cours en ligne : ils se sont introduits dans les classes organisées sur des plateformes de vidéoconférence en ligne pour harceler et troller ** les étudiants et les professeurs. Notamment, « des utilisateurs ont rapporté que des zoom-bombers criaient des insultes raciales, dessinaient des insignes néonazis, partageaient des vidéos explicites ou violentes et faisaient du doxxing – partage d’informations personnelles et confidentielles sur des professeurs et des participants ***. » Le phénomène s’est développé au point que le FBI a émis un avertissement pour les utilisateurs de ce type de plateforme, alertant de la possibilité de ces intrusions ****. |

Derrière l’opportunisme, la menace de l’accélérationnisme

Voir « White Supremacists Embrace “Accelerationism” », art. cit.

Les channels de Telegram sont le principal outil de l’application pour la diffusion à grande échelle. D’une manière générale, les channels (« canaux ») sont des groupes à capacité d’audience illimitée et peuvent être publics ou privés. Les channels publics sont accessibles à toute personne y accédant à l’aide d’un lien ou en recherchant par mot-clé sur Telegram ou sur n’importe quel navigateur de recherche.

L’importance de Telegram parmi les extrémistes violents de droite a également augmenté depuis le début de la pandémie de Covid-19, avec une croissance exponentielle de l’audience des channels associés aux idéologies extrémistes violentes depuis février-mars Selon une étude de l’Institute for Strategic Dialogue (ISD), un canal reliant le supremacisme blanc et le Covid-19 a même connu une croissance de 800 %. Voir Billy Perrigo, « White Supremacist Groups Are Recruiting With Help From Coronavirus – and a Popular Messaging App », time.com, 8 avril 2020, et Hope not hate, « Terrorgram Network: A Spiral Towards Bloodshed », hopenothate.org. uk, s.d.

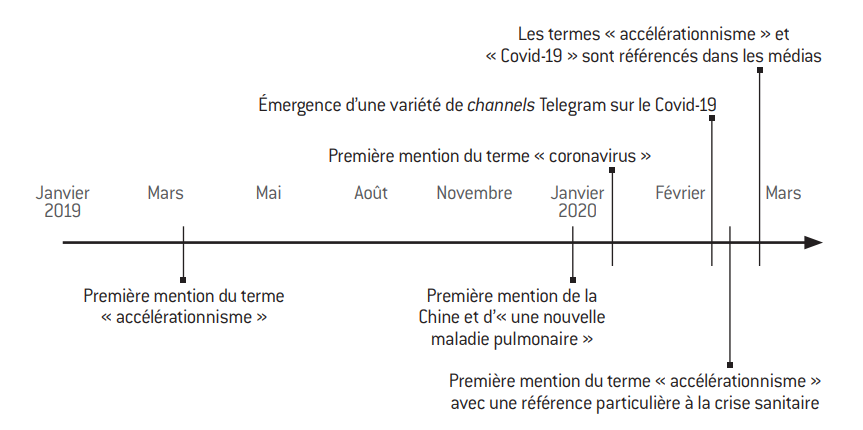

Nous établissons la chronologie d’un sujet de discussion, ici l’accélérationnisme et le Covid-19, en scrutant l’utilisation des termes-clés sur les channels de Telegram (par exemple quand ils sont apparus pour la première fois sur les channels analysés et s’il y a eu une augmentation de leur mention au fil du temps).

Les extrémistes tentent depuis longtemps d’exploiter les périodes d’instabilité et d’insécurité pour diffuser leurs idéologies. Une tendance de plus en plus présente au sein des extrémistes violents de droite depuis un an, et qui reflète particulièrement cette tentative de se nourrir de la polarisation et de l’instabilité est l’accélérationnisme, autrement dit la thèse d’un effondrement accéléré de la société telle que nous la connaissons par des moyens à la fois violents – le terrorisme et la guérilla – et non violents – les manipulations politiques et médiatiques – afin d’accroître les tensions existantes du système et de polariser davantage la société 24.

Sur la base d’un suivi ciblé et d’une analyse du contenu de 100 channels de l’ultradroite, en particulier néonazies, sur l’application de messagerie cryptée Telegram 25, Tech Against Terrorism a étudié comment les discours sur l’accélérationnisme ont fusionné avec les discussions sur la crise de Covid-19. Telegram a été choisie en raison de son importance croissante au sein des cercles de l’ultradroite en ligne, en particulier parmi les néonazis 26. Tech Against Terrorism surveille les channels publics néonazis sur Telegram depuis 2019. Lorsque des rapports sont apparus sur des extrémistes violents utilisant le Covid-19 comme impulsion pour des discussions accélérationnistes en ligne, il a été décidé d’analyser comment cela s’exprimait sur Telegram. Pour ce faire, 100 channels ont été sélectionnés sur la base d’un échantillonnage construit selon la méthode dite « en boule de neige » : en commençant par un channel néonazi, nous avons tracé un réseau d’activité néonazie sur la plateforme grâce aux liens partagés sur le channel original et avons inclus les channels publics pertinents dans notre échantillon. Le canal initial a été localisé grâce à une simple recherche par mot-clé de termes néonazis traduisant une adoration d’Hitler, de l’Allemagne nazie ou une haine des communautés juives. Le caractère néonazi des canaux identifiés a ensuite été vérifié. L’analyse des channels échantillonnés et des données récupérées a permis de confirmer les relations existantes entre les différents canaux néonazis.

Les premières discussions concernant l’accélérationnisme sur les channels néonazis de Telegram remontent à 2019 et précèdent donc la pandémie de Covid-19. Les premières discussions autour d’une nouvelle maladie pulmonaire et les mentions de la Chine sur les channels d’extrémistes violents peuvent être situées, quant à elles, entre janvier et février 2020, à peu près au moment où le Covid-19 devient un sujet majeur d’actualité, puis apparaissent ensuite les channels spécifiquement consacrés au Covid-19. Vers mars 2020, l’association entre les discussions sur l’accélérationnisme et la crise du Covid-19 fait son apparition sur Telegram, peu après que l’association des deux commence à être mentionnée dans un certain nombre d’articles d’actualité 27.

Chronologie des mentions de termes-clés dans un échantillon de 100 channels publics néonazis sur Telegram

Source :

Tech Againt Terrorism ; Fondation pour l’innovation politique.

Depuis, les mentions de l’accélérationnisme sur Telegram n’ont cessé d’augmenter. Alors que la pandémie se propageait dans le monde entier, l’accélérationnisme est devenu un sujet central de discussion sur les channels d’extrémistes violents de Telegram. L’une des raisons de cette utilisation plus fréquente du terme au fil du temps est très probablement l’intensification de la couverture médiatique autour de la pandémie et des mesures qu’elle a entraînées. Cela a représenté une condition favorable pour les accélérationnistes, puisque le Covid-19 est devenu un sujet central de discussion publique, surtout au fur et à mesure que la pandémie et les mesures de confinement et autres restrictions créaient plus d’instabilité et de contestation.

Pour mieux comprendre le langage utilisé par les extrémistes violents discutant de la pandémie de Covid-19 sur Telegram, nous avons soumis un channel spécifique à une analyse plus approfondie, choisie parce qu’il est principalement consacré aux discours accélérationnistes et au Covid-19, et fait donc fortement référence à l’idéologie accélérationniste à la lumière de la pandémie mondiale actuelle.

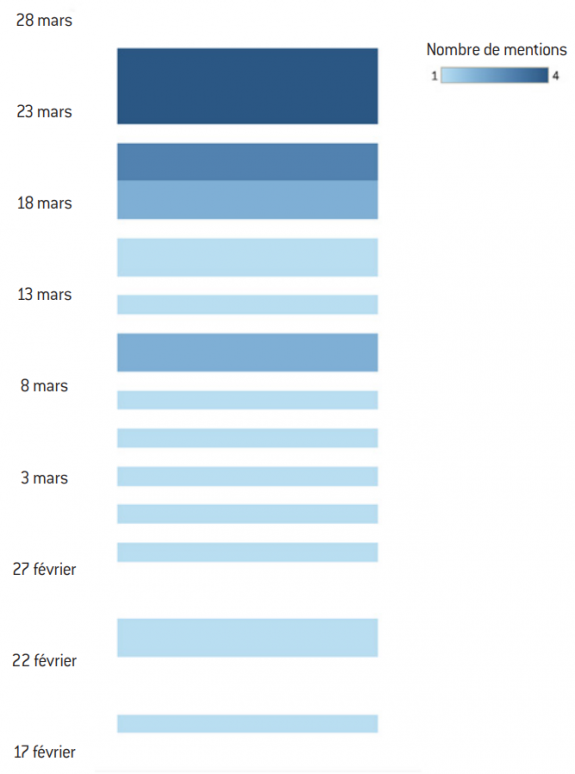

Nous avons procédé à une analyse de contenu et nous avons tracé la mention du terme « accel » au fil du temps sur un channel particulier de Telegram afin de mieux comprendre l’utilisation du langage par ces groupes d’ultradroite. Le terme « accel » a été délibérément choisi pour tenir compte de variations telles que « accélérer », « accélérationniste », « accélérationnisme » ou « accélération ».

Il est important de préciser que toute généralisation de cette analyse doit être traitée avec prudence en raison de la taille restreinte de l’échantillon. Toutefois, étant donné la nature de ce groupe et le nombre assez important de ses membres, elle fournit des indications pertinentes sur l’évolution du langage utilisé par ces milieux.

Mention du terme « accel » du 17 février au 28 mars 2020 sur un channel de Telegram

Source : Tech Againt Terrorism ; Fondation pour l’innovation politique.

Une stratégie pour « arsenaliser » le virus, apparemment couramment discutée, consistait à recommander que les extrémistes infectés par le virus le diffusent délibérément, en ciblant les minorités et les forces de l’ordre.

Voir Michael Colborne, « As world struggles to stop death, far right celebrates Covid-19 », aljazeera.com, 26 mars 2020.

Voir Hunter Walker et Jana Winter, « Federal law enforcement document reveals white supremacist discussed using coronavirus as a bioweapon », yahoo.com, 21 mars 2020.

D’autres chercheurs ont également montré une montée rapide de l’accélérationnisme dans ces canaux, en particulier dans des discussions concernant l’arsenalisation du virus, c’est-à-dire sa transformation en une arme 28, l’accentuation de l’agitation sociale et l’accélération de l’effondrement de la société 29. Cette menace a été reconnue par les forces de l’ordre aux États-Unis à l’échelle fédérale, qui ont fait état de militants violents de droite envisageant de faire du virus une arme à des fins terroristes 30, et elle s’est déjà manifestée dans des événements réels comme nous le verrons dans la section suivante.

Voir Ilham Maad, « Gardiens de la paix », arteradio.com, 4 juin 2020.

Voir Sébastien Bourdon, « At Ukraine’s Asgardrei, A French Connection », bellingcat.com, 1er mai 2020.

Voir Jean-Michel Décugis et Jérémie Pham-Lê, « Ultradroite : Aurélien C., un “suprémaciste” soupçonné de projet terroriste », leparisien.fr, 26 mai 2020.

| France : ultradroite et accélérationnisme

Il pourrait être facile de conclure que des concepts tels que l’accélérationnisme ne sont pas pertinents en France et de considérer le phénomène plus large de l’ultradroite comme un phénomène étranger dont l’influence est limitée dans l’Hexagone. Cependant, on aurait tort de croire à une exception française dans ce contexte. Le militantisme violent d’extrême droite est présent en France, y compris à travers les discours sur une guerre civile ou raciale à venir et sur l’effondrement de notre société actuelle – deux éléments-clés de l’accélérationnisme. On a pu ainsi montrer l’enracinement d’idées haineuses chez certains membres des forces de l’ordre et on a pu constater à cette occasion que les partisans français de l’extrémisme violent évoluent sur les mêmes plateformes en ligne (Bitchute, VK) que leurs homologues internationaux *. Une enquête de la plateforme d’investigation Bellingcat fait également la lumière sur la connexion internationale de l’ultradroite française en exposant la présence d’éléments français dans un festival de musique ouvertement néonazi en Ukraine, en décembre 2019 **. Il est nécessaire d’approfondir les recherches sur les réseaux français d’extrémistes violents afin de comprendre pleinement l’ampleur de la menace dans le pays et la manière dont ces réseaux interagissent avec leurs homologues internationaux. En attendant, la menace ne doit pas être négligée, comme le montre l’arrestation récente d’un homme qui préparait un attentat contre la communauté juive en France ***. |

Des bavardages en ligne aux actions dans le monde réel

Lors de plusieurs manifestations aux États-Unis, des manifestants lourdement armés ont manifesté dans les capitales de plusieurs États à travers le pays.

Voir Thomas Seymat, « Coronavirus : aux États-Unis, extrême droite et complotistes en embuscade », euronews.com, 26 mai 2020.

Ibid.

Voir « The Boogaloo: Extremists’ New Slang Term for A Coming Civil War », adl.org, 26 novembre 2019.

Un mème Internet (Internet meme) est un thème ou un phénomène (image, vidéo, texte…), souvent au départ de nature humoristique, repris et diffusé massivement sur Internet.

Les Proud Boys avaient notamment été bannis de Facebook en La plateforme a pris d’autres mesures contre le gang à la lumière de son exploitation violente des récents troubles sociaux aux États-Unis qui ont suivi la mort de George Floyd. Voir Taylor Hatmaker, « Facebook bans the Proud Boys, cutting the group off from its main recruitment platform », techcrunch.com, 31 octobre 2018, et David Klepper, « Facebook removes nearly 200 accounts tied to hate groups », apnews.com, 6 juin 2020. Dernièrement, les Proud Boys ont attiré l’attention des médias en promouvant le commentaire du président américain Donald Trump, citant leur groupe dans le cadre d’une réponse sur le thème du suprémacisme blanc lors du débat présidentiel du 29 septembre 2020 : « Proud boys, reculez et tenez-vous prêts [Proud boys, stand back and stand by] », qu’ils ont interprété comme un cri de ralliement. Voir « États-Unis : qui sont les ‘Proud Boys’, ces supporters extrêmes de Donald Trump ? », ladepeche.fr, 3 octobre 2020.

Voir Tess Owen, « The Anti-Lockdown Protests are getting weird », vice.com, 17 avril 2020, ainsi qu’un tweet de Mark Pitcavage.

Voir Mark Scott et Steven Overly, « ‘Conspiracy bingo’: transatlantic extremists seize on the pandemic », politico.eu, 12 mai 2020; Christina Goßner, « Anti-lockdown protests in Germany infiltrated by far-right extremists », euractiv.com, 14 mai 2020; et Jan Bielicki, Stefan Braun et Jan Heidtmann, « Diffuse Unruhe erfasst das Land », Courrier international, 16 mai 2020, sueddeutsche.de, traduction sur le site de Courrier international).

Voir Alex Hern, « 5G conspiracy theories fuel attacks on telecom workers », theguardian.com, 7 mai 2020; DamienLeloup,« Les destructions d’antennes téléphoniques 5G augmentent en Europe », lemonde.fr, 20 avril 2020 ; et Julien Lausson, « Pourquoi des antennes 5G sont-elles vandalisées en Europe ? », numerama.com, 13 avril 2020.

Voir Alexander Meleagrou-Hitchens et Blyth Crawford, art. cit.

Voir Jean-Michel Décugis et Jérémie Pham-Lê, « Ultradroite : Aurélien , un “suprémaciste” soupçonné de projet terroriste », art. cit.

Le 15 mars 2019, un militant suprémaciste blanc âgé de 28 ans et adepte de la mouvance Alt-Right (mouvement nationaliste blanc d’extrême droite basé aux États-Unis) a perpétré deux fusillades de masse dans deux mosquées différentes de Christchurch, en Nouvelle-Zélande, faisant 51 morts et 49 blessés.

Coïncidant avec le moment où les premières mesures de confinement étaient appliquées en France.

Voir Pete Williams, « Missouri man planned to bomb hospital during pandemic to get attention for white supremacist views », nbcnews.com, 30 mars 2020, et Bridget Johnson, « White Supremacist in Covid-19 Hospital Bomb Plot Allegedly Wanted to Attack Power Grid », hstoday.us, 31 mars 2020.

La désinformation et les propos tenus par l’ultradroite ne se sont pas limités aux plateformes en ligne. Ils se sont aussi manifestés à travers des activités et des événements du monde « réel » par le biais de manifestations anti-confinement dans le monde entier, d’attaques contre des infrastructures 5G, de harcèlement de travailleurs des télécommunications et d’attaques déjouées.

Des manifestations anti-confinement critiquant et demandant la fin de ces mesures au motif qu’elles restreignent la liberté ont eu lieu dans toute l’Europe (notamment en Allemagne, en Suisse, en Espagne et en Italie). Les manifestations aux États-Unis ont toutefois bénéficié d’une plus grande attention médiatique, probablement en raison de leur ampleur et de la militarisation dont certaines ont fait l’objet 31. Si les manifestations contre le confinement représentent un large éventail de convictions politiques, la plupart des participants n’ayant aucune affiliation avec l’ultradroite, de nombreux groupes violents de droite y ont vu une occasion idéale pour bénéficier de publicité et diffuser leur idéologie 32. Ainsi, si certains groupes d’ultradroite ont été parmi les premiers à organiser de tels rassemblements aux États-Unis, ils ont ensuite commencé à se fondre dans les manifestations classiques 33. Les Boogaloo 34, un mème Internet 35 américain devenu mouvement extrémiste appelant à une seconde guerre civile, et les Proud Boys 36, un gang néofasciste américain, ont été parmi les premiers militants d’ultradroite à être repérés lors de manifestations contre le confinement, affichant ouvertement des symboles associés à l’idéologie de l’ultradroite américaine 37. Ces manifestations ont peu à peu vu croître la présence d’extrémistes en leur sein, à mesure que ceux-ci ont continué à tirer profit de la pandémie et des mesures de confinement et se sont rendu compte que les théories conspirationnistes et ce type de rassemblements étaient un excellent moyen de gagner en publicité et de communiquer leurs idées. Si le lien entre extrémistes et rassemblements anti-confinement a été le plus frappant aux États-Unis, la même combinaison de théories conspirationnistes, de sentiments antigouvernementaux et de motifs extrémistes peut être observée en Europe. En Allemagne, par exemple, les manifestations ont été soutenues par la droite populiste tout en étant le théâtre d’un mélange de partisans des théories conspirationnistes. Il est particulièrement important de rappeler ici le rôle de l’ultradroite et des éléments néonazis dans la diffusion des théories du complot 38. D’une certaine manière, les rassemblements anti-confinement représentent la manifestation dans le monde physique du croisement entre les idéologies extrémistes et le débat public sur la pandémie.

Les théories conspirationnistes liées au Covid-19 se sont également matérialisées par des actes de violence physique. Les théories du complot liant le virus aux technologies 5G, en particulier, ont conduit à des attaques contre des infrastructures de télécommunication et des travailleurs au Royaume-Uni et aux Pays-Bas 39. Ce phénomène a été encouragé par les accélérationnistes qui y ont vu une chance de provoquer davantage d’agitation sociale 40. Au-delà de ces violences, physiques et psychologiques, contre les travailleurs du secteur des télécommunications, des plans d’attaques issus de militants violents d’extrême droite ont été déjoués aux États-Unis et en France depuis le début de la pandémie. Le 26 mai 2020, un homme a ainsi été arrêté en France pour avoir planifié une attaque contre la communauté juive 41. L’homme, dont le profil sur les réseaux sociaux témoignait de son implication dans la nébuleuse néonazie et sur lequel on pouvait trouver une traduction française du manifeste du tireur de Christchurch 42, serait devenu de plus en plus violent au cours des semaines précédant son arrestation 43 et aurait manifesté un intérêt particulier pour la réouverture des lieux de culte en France une fois le confinement levé. À ce stade de l’enquête, nous ne pouvons que supposer un lien entre l’intérêt accru de cet homme pour l’ultradroite au cours des dernières semaines et la pandémie, qui aurait agi comme catalyseur de son action. Cependant, pour d’autres plans déjoués aux États-Unis, le rapport entre Covid-19 et accélérationnisme a été clairement établi. Au début de la pandémie, un suprémaciste blanc a notamment été tué lors de son arrestation par le FBI alors qu’il planifiait un attentat contre un hôpital accueillant des patients atteints du Covid-19. Bien que l’individu ait été un partisan du suprémacisme blanc et militant pour une « insurrection révolutionnaire » avant la pandémie, les détails d’une discussion qu’il a eue avec un agent des forces de l’ordre sous couverture révèlent que le Covid-19 a accéléré son passage à l’acte. L’individu a vu l’attention médiatique accrue accordée au secteur de la santé comme une occasion de capter l’attention du public et de promouvoir les idées extrémistes 44. Ces plans d’attaque déjoués montrent à quel point l’opportunité que représente le virus pour les extrémistes, en particulier dans le cadre de discussions sur l’accélérationnisme, constitue une réelle menace pour la sécurité dans les démocraties occidentales. Cette menace ne doit en aucun cas être sous-estimée car les attaquants d’extrême droite de type « loups solitaires » ont démontré leur capacité à agir sur la base de leurs convictions haineuses au cours de ces dernières années – 2019 étant une année particulièrement tragique à cet égard, puisque le monde a été témoin de quatre grands attentats terroristes motivés par l’extrême droite, en Nouvelle-Zélande, aux États-Unis et en Allemagne, dont le tragique attentat contre les mosquées de Christchurch et la fusillade d’El Paso.

La réponse des plateformes en ligne et l’avenir de la modération de contenu

Voir Till Baaken, « YouTube’s Role as a Platform for Extremism », gnet-research.org, 2 mars 2020.

« Messages that have been identified as “highly forwarded” – sent through a chain of five or more people – can only be forwarded to a single person » (Casey Newton, « WhatsApp puts new limits on the forwarding of viral messages », theverge.com, 7 avril 2020).

Les extrémistes violents de droite ont donc profité de la pandémie pour exploiter et déformer le paysage médiatique et informationnel, montrant une fois de plus leur capacité à mettre les plateformes en ligne au service de leurs propres agendas. Cependant, les plateformes en ligne – en particulier les réseaux sociaux et les applications de messagerie – ont rapidement réagi à la propagation des théories conspirationnistes, à la mésinformation et à la désinformation autour du Covid-19 sur leurs sites. Bien qu’elles n’aient pas nécessairement ciblé les extrémistes violents, les changements introduits dans leurs politiques de modération des contenus affectent aussi la capacité de ces derniers à tirer profit de la pandémie. Nous verrons plus loin ce que ces changements signifient pour l’avenir de la modération de contenu en ligne.

Dans le but de freiner la propagation des nuisances liées aux mauvaises informations propagées sur le Covid-19 en ligne, un certain nombre de plateformes Internet ont modifié leurs normes de contenu, élargissant la définition des contenus inacceptables afin d’interdire ou de ralentir la propagation des théories du complot, de la mésinformation et de la désinformation liées au virus. Parmi les exemples les plus marquants, on peut citer la décision de Youtube d’interdire les vidéos conspirationnistes reliant le coronavirus aux réseaux 5G (une mesure particulièrement bienvenue, selon certains experts, compte tenu des discussions existantes sur la possibilité qu’offre Youtube aux extrémistes pour atteindre de larges publics 45), ainsi que la suppression par Twitter de toute information contraire aux directives sanitaires officielles et les nouvelles restrictions mises en place par WhatsApp sur le transfert de messages (« les messages identifiés comme “souvent transférés”, envoyés à travers une chaîne de cinq personnes ou plus, ne peuvent être transférés qu’à une seule personne 46 », au lieu de cinq habituellement).

Des changements aussi rapides dans les politiques relatives aux plateformes en ligne soulèvent d’importantes questions concernant les stratégies de modération du contenu (Content Moderation, COMO), mais aussi quant aux défis inhérents à la lutte contre l’utilisation terroriste et extrémiste d’Internet et contre la désinformation dans le respect des droits fondamentaux.

Pour en savoir plus sur les normes de contenu et la modération de contenu pour les plateformes technologiques, voir « Protecting free expression in the era of online content moderation », accessnow.org, mai 2019, ainsi que les sites de Tech Against Terrorism et du GIFTC.

| Les normes de contenu

Les « normes de contenu » désignent l’ensemble des lignes directrices dont dispose une plateforme en ligne pour définir ce qui est accepté ou interdit sur son site ou son application, y compris les conditions d’utilisation, les directives communautaires et les chartes de bon usage. Ces normes sont le principal moyen pour une plateforme d’informer ses utilisateurs sur ce qui est interdit ou non, et donc sur sa politique de modération des contenus et sa mise en œuvre, et sont donc essentielles pour garantir la transparence et permettre d’assurer la responsabilité d’une plateforme vis-à-vis de ses utilisateurs. Tech Against Terrorism conseille aux entreprises technologiques d’indiquer clairement ce qu’elles attendent de leurs utilisateurs et comment elles entendent faire appliquer leurs politiques de modération en cas de violation, ainsi que d’interdire explicitement l’utilisation terroriste dans leurs normes de contenu. Cette interdiction est également une condition d’adhésion au Global Internet Forum to Counter Terrorism (GIFCT), une coalition dirigée par l’industrie et formée par Facebook, Twitter, Youtube et Microsoft, qui collabore avec un large éventail d’ONG, d’experts universitaires et de gouvernements *. |

« Dans sa forme la plus élémentaire, le machine-learning consiste à utiliser des algorithmes pour analyser des données, en tirer des enseignements, puis faire une détermination ou une prédiction sur un sujet donné. Ainsi, plutôt que de coder à la main des procédures avec un ensemble d’instructions spécifiques pour accomplir une tâche particulière, la machine est “formée” à l’aide de grandes quantités de données et d’algorithmes qui lui donnent la capacité d’apprendre comment accomplir la tâche » (« Machine learning at its most basic is the practice of using algorithms to parse data, learn from it, and then make a determination or prediction about something in the So rather than hand-coding software routines with a specific set of instructions to accomplish a particular task, the machine is “trained” using large amounts of data and algorithms that give it the ability to learn how to perform the task », in Michael Copeland, « What’s the Difference Between Artificial Intelligence, Machine Learning, and Deep Learning? », nvidia.com, 29 juillet 2016).

En raison de la sensibilité du travail effectué par les modérateurs de contenu en ligne, et surtout de l’impact potentiel de ce type de travail sur la santé mentale, la modération de contenu par des individus doit généralement être effectuée dans un cadre de travail professionnel et peut difficilement être adaptée à un environnement de travail à domicile. C’est pourquoi, pendant la pandémie, les plateformes en ligne ont eu de plus en plus recours à des outils de modération automatisés.

Voir Emma Llansó, « Covid-19 content moderation research letter », cdt.org, 22 avril 2020.

Face à l’augmentation massive de vidéos supprimées entre avril et juin 2020 dans le contexte de la crise du Covid-19 suite au recours à la modération automatisée, la plateforme YouTube a d’ailleurs décidé de revenir à son système de modération hybride, mêlant intelligence artificielle et contrôle humain. Voir Morgane Tual, « Après avoir favorisé les algorithmes pour modérer les contenus, YouTube fait marche arrière », lemonde.fr, 22 septembre 2020.

Human Rights Watch a récemment publié un rapport sur le dilemme de la modération de contenu et de la suppression de preuves concernant d’éventuels crimes de guerre. Dans ce rapport, l’ONG explique également comment la Terrorist Content Analysis Platform (TCAP) de Tech Against Terrorism peut être une réponse à ce problème. Voir « Les plateformes de médias sociaux suppriment des preuves potentielles de crimes de guerre », Human Rights Watch, 10 septembre 2020.

La réaction rapide des plateformes en ligne, adaptant leurs politiques et leurs offres de services pour protéger les utilisateurs et la société dans son ensemble, a amené un certain nombre de personnes à se demander pourquoi une telle réaction n’est pas la norme. Plus que toute autre chose, la question devrait être : quels types de changements permettent une réponse aussi rapide et comment pouvons-nous évaluer ces mesures lorsque cette crise sera terminée ?

Une partie de la réponse tient dans le fait qu’en 2020 les plateformes en ligne ont la capacité de s’appuyer pleinement sur les systèmes, sur les stratégies et sur les partenariats qu’elles ont efficacement mis en place depuis 2017 et la création du GIFCT. Cela signifie que, pour faire face au risque accru d’utilisation abusive de leurs plateformes, ces entreprises ont pu capitaliser sur l’investissement précédemment réalisé sur la recherche de politiques, sur la mise en place de solutions efficaces pour la modération des contenus et sur la collaboration avec des chercheurs, des groupes issus de la société civile, des experts de terrain et des fact-checkers. En effet, ces dernières années, les plateformes en ligne ont fait de plus en plus d’efforts pour répondre efficacement à l’utilisation d’Internet par les terroristes. Cela passe par une attention accrue portée à la modération du contenu, notamment par la mise au point de solutions automatisées, à travers le machine-learning 47, de projets visant à faire barrage aux discours extrémistes et terroristes, ainsi que par le Global Internet Forum to Counter Terrorism (GIFCT). Le consortium de partage de hash (une empreinte digitale unique à une image ou une vidéo en ligne permettant de l’identifier automatiquement, facilitant la détection de contenus illégaux, aussi bien avant qu’après la mise en ligne selon les systèmes en place) et le système de protocole de crise du GIFCT démontrent particulièrement cet engagement. La crise du Covid-19 a également souligné l’importance du bon fonctionnement et de la solidité des canaux public-privé entre les gouvernements et les entreprises du secteur technologique. Toutefois, la pandémie et les changements rapides de la part des plateformes en ligne présentent des risques d’empiétement sur les politiques de modération que celles-ci avaient progressivement mises en place ces dernières années, petit à petit et de manière transparente.

Ce phénomène est exacerbé par le fait que, durant cette période, l’humain est plus que d’habitude tenu à l’écart de tout ce qui touche à la modération, notamment parce que de nombreux employés doivent travailler depuis chez eux afin de respecter les mesures de distanciation sociale 48. Bien qu’elle soit déjà largement utilisée par les grandes plateformes dans leurs efforts de modération du contenu à grande échelle, et pour contrer l’utilisation d’Internet par des terroristes, l’intelligence artificielle, plus particulièrement le machine-learning, en est encore à sa phase initiale. À l’heure actuelle, cette technologie ne permet pas de saisir suffisamment bien les nuances et le contexte d’une publication, éprouvant, par exemple, des difficultés à distinguer un contenu terroriste d’un contenu informatif de type journalistique sur le terrorisme. Si le développement de ces technologies doit être encouragé, la modération fondée sur l’intervention humaine reste essentielle, notamment pour éviter l’excès de censure et le retrait de contenus licites. En outre, ces technologies nécessitent la mobilisation de quantités importantes de données, ce qui reste une entrave à leur recours pour combattre l’utilisation d’Internet par des terroristes et des extrémistes – d’autant plus si l’on souhaite s’appuyer sur des technologies prédictives.

Dans ce contexte, le Center for Democracy and Technology (CDT) a publié un communiqué faisant état de préoccupations partagées par des acteurs de l’industrie et des ONG concernant le recours accéléré des plateformes en ligne à la modération automatisée pendant cette période – notamment l’utilisation du machine-learning plutôt que la modération humaine pour détecter, faire remonter et même statuer sur les contenus illicites sur leur site 49.

Le recours accru à la modération automatisée augmente le risque de faux positifs dans le retrait de contenus licites et soulève des questions sur la responsabilité des décisions de retrait 50. La situation se complique encore lorsque le contenu préjudiciable provient d’utilisateurs qui ne sont pas extrémistes eux-mêmes ou dont l’affiliation extrémiste est quelque peu floue, ou encore lorsque le contenu relève d’une « zone grise ». En effet, il convient de souligner qu’en raison de l’absence de désignation des terroristes et extrémistes violents de droite comme entités terroristes par les gouvernements, ces groupes existent bien souvent dans une « zone grise » en termes de légalité. Le risque le plus important demeure que des contenus dénonçant des violations des droits humains, y compris des contenus journalistiques pouvant servir de preuve de ces violations, soient automatiquement retirés 51. Ce risque est d’autant plus grave que dans certains pays les garanties constitutionnelles ont été affaiblies durant la crise du Covid-19.

Un impact durable sur les libertés fondamentales

Reporters sans frontières, « Censure et attaques. Le journalisme en quarantaine », rsf.org.

Voir Berhan Taye et Felicia Anthonio, « #KeepItOn: internet shutdowns during Covid-19 will help spread the virus! », accessnow.org, 17 mars 2019.

Voir « Exigimos respeto a la libertad de expresión y al derecho a la protección de datos personales en Honduras », accessnow.org, 20 mars 2020.

« … that false information about the pandemic could lead to health concerns, panic and disorder » (David Kaye, Harlem Désir et Edison Lanza, « Covid-19: Governments must promote and protect access to and free flow of information during pandemic – International experts », ohchr.org, 19 mars 2020).

« Resorting to other measures, such as content take-downs and censorship, may result in limiting access to important information for public health and should only be undertaken where they meet the standards of necessity and proportionality » (ibid.).

Sur ces processus, voir Tech Against Terrorism, « The Online Regulation The European Union », 19 octobre 2020.

Pour en savoir plus sur le problème posé par le filtrage de téléchargement, voir Diego Naranjo, « Terrorist content online regulation: time to get things right », edri.org, 16 mars 2020.

LOI n°2020-766 du 24 juin 2020 visant à lutter contre les contenus haineux sur internet, version consolidée du 7 septembre 2020.

De nombreux rapports issus de groupes de défense des droits fondamentaux indiquent que la crise de Covid-19 est utilisée par certains gouvernements dans le monde pour « établir ou renforcer leur contrôle sur les médias nationaux, et aggraver la censure d’État 52 ». Les inquiétudes au sujet des théories conspirationnistes, de la désinformation et des menaces émises par des acteurs violents cherchant à profiter d’une telle situation, peuvent ainsi devenir des prétextes à une politique de censure. Des gouvernements autoritaires ont déjà utilisé la menace à la sécurité nationale que peut représenter l’usage d’Internet par des réseaux terroristes et extrémistes pour tenter de forcer les plateformes en ligne à étouffer les voix dissidentes ou à restreindre l’accès à l’information. Il n’est peut-être pas surprenant qu’au plus fort de cette crise sanitaire, plusieurs gouvernements aient bloqué l’accès à Internet dans certaines parties de leur territoire ou l’aient limité à certains sites 53. D’autres ont temporairement révoqué les garanties constitutionnelles, notamment en matière de liberté d’expression 54. C’est en partie pour cette raison qu’il est si important d’établir des normes claires en matière de contenus : elles servent de critères à partir desquels les utilisateurs peuvent se défendre contre les suppressions illégales ou ponctuelles de contenus en ligne. Les tentatives de criminalisation des informations relatives à la pandémie peuvent susciter la méfiance à l’égard des institutions, retarder l’accès à des informations fiables et avoir un effet paralysant sur la liberté d’expression. Il s’agit de faire en sorte que les plateformes soient contrôlées selon des procédures respectueuses de l’État de droit, précisément parce qu’il s’agit d’une crise et de circonstances exceptionnelles.

Dans une déclaration conjointe, David Kaye, rapporteur spécial des Nations unies sur la promotion et la protection du droit à la liberté d’opinion et d’expression, Harlem Désir, représentant de l’Organisation pour la sécurité et la coopération en Europe (OSCE) pour la liberté des médias, et Edison Lanza, rapporteur spécial de la Commission interaméricaine des droits de l’homme (CIDH) pour la liberté d’expression, ont souligné l’importance pour les gouvernements et les entreprises technologiques de travailler ensemble pour fournir des informations fiables en réponse à des informations fausses sur la pandémie qui seraient capables « d’entraîner des problèmes sanitaires, des épisodes de panique et des troubles 55 ». Mais ils ont également souligné que « le recours à d’autres mesures, telles que le retrait de contenus et la censure, peut avoir pour conséquence de limiter l’accès à des informations importantes pour la santé publique et ne devrait être entrepris que si elles répondent aux normes de nécessité et de proportionnalité 56. »

Ces considérations sont encore plus importantes à la lumière des récents développements dans le monde de la réglementation du contenu en ligne : l’Union européenne est en train de rédiger sa nouvelle proposition de loi sur la régulation des contenus en ligne 57. Elle pourrait conduire à l’imposition de filtrage au téléchargement ou upload filters, et donc à une plus grande dépendance à l’égard des outils automatisés 58. Le filtrage au téléchargement s’appuie sur des programmes automatisés qui analysent les données selon certains critères et permettent ou empêchent le chargement d’un contenu sur une plateforme en ligne selon le résultat de l’analyse.

En parallèle, la France a récemment promulgué une nouvelle loi visant à lutter contre les contenus haineux sur Internet, dite « loi Avia » 59, qui aurait obligé les plateformes en ligne à supprimer les contenus terroristes notifiés dans un délai d’une heure (le contenu de la loi a finalement été largement censuré par le Conseil constitutionnel avant son adoption par l’Assemblée nationale). De l’autre côté de l’Atlantique, le président américain a signé un décret qui, bien que contesté pour des raisons de constitutionnalité, pourrait supprimer l’actuelle protection juridique qui permet aux plateformes en ligne de ne pas être légalement responsable des contenus générés par leurs utilisateurs. Comme pour d’autres lois de régulation en ligne adoptées en Europe, notamment la loi allemande Netzwerkdurchsetzungsgesetz (NetzDG) de 2017 destinée à sanctionner les fake news et les contenus haineux sur les réseaux sociaux, les défenseurs des droits fondamentaux et des groupes issus de la société civile ont critiqué ces lois qui pourraient inciter à une modération trop zélée et conduire à la suppression de contenus licites. Néanmoins, beaucoup considèrent également ces lois comme des mesures nécessaires pour garantir que les plateformes en ligne disposent de procédures de responsabilité et de transparence à l’égard de leurs utilisateurs et de la société dans son ensemble. Ce qui est clair, cependant, c’est que les plateformes en lignes et les gouvernements doivent trouver un équilibre entre, d’une part, la lutte contre les dangers et les nouvelles menaces en constante évolution qui pèsent sur la société dans la sphère en ligne et, d’autre part, la protection des droits fondamentaux.

Commentaires sur la loi Avia, visant à lutter contre les contenus haineux sur internet

La loi Avia est la première loi non liée au Covid-19 à avoir été adoptée par le Parlement français depuis mars 2020, deux jours seulement après la fin du confinement dans le pays, en mai 2020. Cela a conduit à certains commentaires selon lesquels le gouvernement français aurait utilisé la vague de désinformation liée à la pandémie pour la faire adopter malgré ses critiques. Voir Simon Chandler, « France Social Media Law Is Another Coronavirus Blow To Freedom Of Speech », forbes.com, 14 mai 2020.