L'intelligence artificielle : l'expertise partout accessible à tous

Introduction

L’omniprésence de l’intelligence artificielle

Qu’est-ce que l’intelligence ?

Une brève histoire de l’intelligence artificielle et de ses acteurs principaux

Les grandes ruptures de 2011

Du big data au data mining

L’importance e l’apprentissage

Les grands acteurs de l’intelligence artificielle

L’impact sur les métiers

La médecine

Le futur

Conclusion

Résumé

L’intelligence artificielle est l’un des sujets de bouleversements majeurs qui affectent notre époque. Rarement une évolution technologique n’aura engendré autant d’opportunités de résolutions de problèmes, autant de changements dans les usages, autant de peurs.

Pourtant, il ne s’agit absolument pas d’une rupture technologique. L’intelligence artificielle s’inscrit dans la continuité de l’informatique dont la puissance de calcul ne cesse de croître, augmentée parla disponibilité de grandes masses de données que le monde Internet sait agréger.

L’intelligence artificielle ne se résume pas à gagner les championnats du monde de GO ; elle permet maintenant aux voitures de rouler sans conducteurs, aux robots de devenir de plus en plus autonomes, aux médecins de faire des diagnostics plus fins, aux avocats de faire des contrats plus précis. Après l’information, puis la connaissance, c’est maintenant au tour de l’expertise d’être disponible partout, accessible à tous. Sa rareté, qui jusqu’ici a été source d’un profit légitime mais considérable, est en passe de se transformer en abondance. Seuls les experts les plus pointus, qui auront compris comment tirer parti de la nouveauté qu’apporte l’intelligence artificielle, survivront. Mais c’est potentiellement une très bonne nouvelle pour l’ensemble de l’humanité.

Serge Soudoplatoff,

Expert de l’Internet, cofondateur de Sooyoos, Scanderia et Mentia.

Serge Soudoplatoff est un expert, chercheur et entrepreneur de l’Internet. Il effectue de nombreuses conférences sur les mutations induites par Internet et l’impact sur les secteurs d’activités économiques et sociales. Il a cofondé plusieurs entreprises, dont Highdeal en 2000 (vendue à SAP en 2007), Sooyoos en 2008, une agence de développement de sites applicatifs, et Scanderia en 2013, une entreprise qui développe des jeux à composante éducative. Serge investit et conseille de nombreuses start-up françaises (VastPark, KZero, Hello Mentor, Mugeco, Nuukik…).

Introduction

Voir Laurent Alexandre, La Guerre des intelligences, JC Lattès, 2017.

Voir Robin Rivaton, Relancer notre industrie par les robots (1) : les enjeux, Fondation pour l’innovation politique, décembre 2012.

Voir « China Internet Statistics 2017 », chinainternetwatch.com.

Il faut avoir le courage de regarder les choses avec franchise et sans crainte : nous sommes au début d’une ère nouvelle qui n’épargnera aucun secteur. La combinaison d’algorithmes de plus en plus sophistiqués, de puissances de calcul croissantes, de données qualifiées disponibles dans des bases reliées entre elles grâce à des réseaux de plus en plus rapides, le tout étant disponible sur des smartphones connectés en permanence, va avoir un impact énorme. La révolution du numérique est encore devant nous. Nous n’en sommes qu’aux balbutiements.

La crainte n’est pas tellement que la machine supplante l’humain, sujet que nous aborderons à la fin de cette note, mais surtout que l’impact sur les activités humaines soit disruptif. Ce ne sont pas seulement certains métiers dits manuels, tels les chauffeurs de taxi ou les conducteurs de poids lourds, qui vont souffrir, mais la quasi-totalité des métiers dits intellectuels (notaires, banquiers, avocats, médecins, etc.) qui risquent de connaître des difficultés. La raison en est simple : plus la part de réflexion et de créativité requise dans certains métiers est faible, plus il est facile de remplacer ceux-ci par des systèmes informatiques qui se fondent sur la logique. La caricature évidente en est la bureaucratisation, des emplois. Pendant longtemps, dans les hautes fonctions de l’administration publique, on s’est protégé en changeant constamment les règles, avec un coût informatique de reprogrammation élevé. L’intelligence artificielle est non seulement capable de digérer des milliers de pages de réglementation, mais elle peut aussi apprendre en continu. À l’inverse, un être humain ne peut à lui seul absorber, pour citer un exemple parmi tant d’autres, l’indigeste code du travail et ses variations. En réalité, comme le préconise par exemple Laurent Alexandre1, la meilleure manière de résister au chômage de masse des « cols blancs » est de favoriser la créativité, et ce dès l’apprentissage lors de la petite enfance. Donnons un exemple de créativité disruptive : la start-up américaine Lemonade, qui assure les locataires et propriétaires d’appartements. Son slogan est « 90 seconds to get insured, 3 minutes to get paid » (« 90 secondes pour être assuré, 3 minutes pourêtre indemnisé »). L’assurance coûte 5 dollars par mois pour les locataires et 25 dollars pour les propriétaires2. Cela est possible grâce à un moteur d’intelligence artificielle couplé avec un agent conversationnel, ou chatbot, un logiciel qui crée une offre d’assurance à partir de données que le client lui fournit via une interface. La compagnie est créditée d’un excellent rating (notation financière obtenue par une entreprise par rapport à son risque de faillite) et se permet même de reverser ses surplus financiers à des associations caritatives, choisies par ses clients.

Face à ces changements profonds, il est difficile pour les dirigeants et tous les professionnels de réagir. La France est traditionnellement un pays fortement producteur d’innovations technologiques, mais en est malheureusement très peu consommatrice. Concernant la robotique, la France se situe à la pointe de la recherche comme l’a montré Robin Rivaton, mais est de plus en plus en retard en termes d’usages de cette robotique3. Le numérique ne prend son sens que si nous cassons la logique des silos, ce qui revient à faciliter une communication transversale et accessible entre les différents services d’une entreprise, d’une administration, d’un État. Or nous tardons à le faire afin de protéger les équilibres des pouvoirs et d’éviter la question de la véritable efficacité du système.

L’hyper protection du citoyen face aux révolutions technologiques peut donner l’illusion d’offrir des mécanismes d’amortissement, mais ce n’est que retarder le moment où l’évidence des performances supérieures de l’intelligence artificielle ne pourra plus être contredite. Et rappelons qu’en conséquence, cela aura engendré une perte de compétences pointues, qui ont toujours besoin de confronter la théorie avec les usages et qui auront cherché ailleurs des contextes plus favorables. Ainsi, le Français Yann Le Cun, l’une des sommités mondiales en matière d’intelligence artificielle, travaille aujourd’hui pour Facebook, après avoir refusé une offre de Google4.

De plus, ce ne sont plus seulement les États-Unis qui engendrent des technologies et des start-up disruptives. S’il est vrai que le contexte de l’actuelle administration américaine est peu favorable à l’innovation, le pays possède néanmoins des mécanismes éprouvés pour empêcher tout blocage du progrès scientifique. Par ailleurs, la Chine possède d’ores et déjà un niveau de connaissances extrêmement élevé : en juillet 2017, le gouvernement chinois a publié un plan stratégique, avec comme objectif de devenir en 2030 le leader mondial en intelligence artificielle, tant sur les logiciels que sur les matériels. La Chine va fabriquer ses propres puces spécialisées pour ne plus dépendre des fournisseurs américains. Le pays possède surtout une réserve d’usages énorme, donc une réserve de données gigantesque. Rappelons qu’à la mi-2016, il y avait 751 millions d’internautes en Chine5, soit l’équivalent de la population du continent européen. Si la Vieille Europe continue de produire des compétences pointues, le contexte de délitement politique qui y règne rend difficile l’implantation d’une stratégie ambitieuse nécessaire pour qu’elle joue un rôle majeur en intelligence artificielle et que les innovateurs trouvent la masse critique des usages nécessaire à leur épanouissement.

Ce n’est pas seulement au niveau de la production de connaissances qu’il faut mesurer le progrès, car nous sommes dans un moment où cette production s’accélère et est devenue mondiale, mais dans la capacité de ces connaissances à engendrer des innovations qui vont rencontrer des usages.Le challenge de tout métier, intellectuel ou autre, sera de se reconfigurer pour tirer parti de l’énorme potentiel de développement qu’apporte l’intelligence artificielle. C’est à cette aune que l’on mesure le progrès des peuples.

L’omniprésence de l’intelligence artificielle

Déjà, un premier élément rassurant : l’intelligence artificielle est présente partout, et ce depuis longtemps. Quiconque a eu la chance de rentrer dans un cockpit d’Airbus A380 a probablement été surpris de la présence d’un objet assez inhabituel dans ce lieu : un clavier d’ordinateur entre le pilote et le tableau de bord. Dans cet avion, beaucoup de phases de vol sont programmées en rentrant des données. Le pilote programme ainsi la bretelle de sortie de la piste d’atterrissage, et l’avion n’a plus qu’à calculer la trajectoire, le point de toucher, le freinage et, in fine, la bretelle de sortie. Le gain premier est l’accroissement de la capacité d’accueil des avions atterrissant à l’aéroport, tout cela sans engendrer de stress supplémentaire pour les pilotes, l’ordinateur les soulageant de tâches très complexes.

Deux enseignements sont à tirer de cette observation. Tout d’abord, cela ne serait pas possible sans la capacité croissante de calcul des ordinateurs, sans la possibilité d’avoir des commandes de vol entièrement électriques, sans des langages de programmation puissants permettant d’élaborer des programmes parfaits, et surtout sans une approche systémique de gestion de projets rendant opérable un avion de 800 passagers muni de 530 kilomètres de câbles comme système nerveux de vol. Mais, surtout, le pilote n’a pas été remplacé : il reste toujours le maître à bord et peut brancher ou débrancher tel ou tel niveau d’automatisation car il sait effectuer aussi la même manœuvre « manuellement ». Le système ordinateur et les commandes de vol sont le support technologique du pilotage. En revanche, le métier de pilote a considérablement changé. Pour les pionniers de l’aviation, un avion se pilotait « aux fesses », c’est-à-dire par les sensations physiques ; aujourd’hui, les pilotes sont des ingénieurs qui allient une vision systémique de la machine à une capacité de manœuvrer l’engin dans un environnement très hostile. Cette évolution traduit une véritable mutation du métier.

Il n’y a pas de séparation franchement nette entre ce qui est de l’intelligence artificielle et ce qui ne l’est pas ; il y a de fait un continuum entre les ordinateurs qui réalisent des tâches simples et ceux qui réalisent des tâches complexes. Le monde est vaste mais continu, depuis le distributeur de billets de banque dont le rôle est de vérifier le code du client et de délivrer le nombre de billets nécessaires pour atteindre le montant désiré, au système de reconnaissance facial de Facebook qui tague toutes les photos de votre « mur » et retrouve automatiquement toutes les personnes qui ont déjà un profil Facebook (fonctionnalité actuellement interdite en Europe). Dans le cas du distributeur de billets, l’« intelligence » se résume à des règles simples, qui sont des inférences logiques de type « si-alors » : si le code rentré est faux, alors le signaler ; si c’est la troisième fois, alors avaler la carte, etc. Mais la logique étant une forme d’intelligence, il est alors facile d’argumenter que tout programme informatique relève, quelque part, de l’intelligence artificielle. John McCarthy, l’un des fondateurs de l’intelligence artificielle et inventeur du nom, disait :

« Dès que ça fonctionne, ce n’est plus de l’intelligence artificielle. » Le terme « intelligence artificielle » serait donc consacré uniquement à ce qui relève de la recherche. Ceci est devenu moins vrai depuis l’avènement du big data, comme nous le montrerons plus loin.

Si vous avez un compte Gmail, vous avez certainement remarqué que certains courriels sont automatiquement redirigés vers la valise des spams, avec parfois de faux positifs, mais rarement de faux négatifs. Si vous avez un compte Amazon, vous avez constaté qu’Amazon vous propose des produits en lien avec vos achats, mais aussi avec votre historique de navigation, et ce de manière très pertinente. Si vous avez un iPhone, vous avez peut-être parlé à Siri, vous lui avez peut-être même, par amusement, donné des ordres dans un langage grossier : c’est efficace et aussi très drôle. Si vous avez une carte American Express, vous avez eu la surprise d’avoir une alerte vous informant d’une dépense incongrue. Si vous lisez Le Monde ou Les Échos en version électronique, vous avez peut-être été surpris de la rapidité avec laquelle les résultats des élections législatives ou municipales vous ont été présentés en détail. Le point commun entre tous ces exemples est un moteur d’intelligence artificielle. Bien entendu, il est totalement différent d’un produit à l’autre, plus ou moins sophistiqué, mais dans tous les cas il s’agit d’algorithmes censés reproduire ce qu’un être humain aurait fait, mais justement ici sans intervention humaine, avec une qualité très proche et sur de grands ensembles. À part le fait d’être artificielle, où se situe donc l’intelligence dans ces programmes ?

Qu’est-ce que l’intelligence ?

« Intelligence », in Alain Rey (dir.), Dictionnaire historique de la langue française, Le Robert, 2016, p. 1164.

Le mot « intelligence » est dérivé du latin intellegere ou intelligere (« choisir entre »)6. Notons qu’Internet, en amplifiant les mécanismes de renforcement d’informations entre les êtres humains, a fortement contribué à installer le concept d’intelligence collective. L’intelligence est la capacité dynamique de pouvoir faire des inférences entre des stimuli, d’en déduire des abstractions, de créer un langage qui permet de nommer, d’échanger et de faire des liens entre ces abstractions. L’intelligence a permis de définir le concept de contexte, pouvant ainsi expliciter que les liens ne sont pas forcément répétitifs. C’est dans toutes ces capacités que l’humain se distingue des autres mammifères. Non seulement un chien ne sait pas dire « demain », mais il est probable que le concept de « demain » ne soit pas développé dans ses capacités cognitives. Nous avons maintenant des outils pour comprendre le cerveau et nous savons que le développement du cortex cérébral a autorisé l’homme à définir des abstractions. Les fonctions du langage, consubstantielles à l’intelligence, ont été identifiées dans certaines aires du cerveau, les aires de Broca et de Wernicke. Certains animaux possèdent ces aires, mais elles sont fortement développées chez les humains. Il faut noter que ce développement du cerveau explique un phénomène intéressant : la plupart des mammifères naissent quasiment adultes, sauf les humains. Un poulain sait marcher au bout de quelques heures, par exemple. En revanche, c’est parce que le développement du cerveau ne peut se faire in utero (car il serait trop volumineux pour franchir le col de l’utérus) que les humains naissent « trop tôt ». Ce faisant, ils sont soumis très vite à tous les stimuli d’un environnement plus varié que le ventre de la mère. L’impact sur le développement de l’intelligence sera peut-être encore mieux compris avec la découverte du rôle fondamental de l’épigénétique, science étudiant les relations entre les gènes et l’environnement.

Il n’est donc pas facile de définir l’intelligence avec le langage comme seul outil. Un dictionnaire présente la particularité d’être autoréférent, puisque les mots se définissent à l’aide de mots. En revanche, il faut comprendre l’intelligence artificielle comme une tentative de comprendre l’intelligence en utilisant des programmes informatiques.

Une brève histoire de l’intelligence artificielle et de ses acteurs principaux

Voir John McCarthy, Marvin Minsky, Nathaniel Rochester et Claude E. Shannon, « A Proposal for theDartmouth Summer Research Project on Artificial Intelligence. August 31,1955 », AI Magazine, vol. 27, n° 4, hiver 2006,p. 12-14

Voir l’intervention de Hiroshi Ishiguro, « The Future Life Supported by Robotic Avatars », au Global Future 2045 International Congress, New York, 15-16 juin 2013, youtube.com

De tout temps, les humains ont créé des technologies pour se soulager des tâches quotidiennes. Le point d’évolution de l’humanité se produit lorsque l’humain maîtrise le feu : les aliments cuits sont plus faciles à digérer. Il y a besoin de moins de neurones dans notre cerveau bas, celui qui gère la digestion, et donc l’énergie disponible permet d’accroître notre cerveau haut. Ainsi l’être humain se trouve en haut de la chaîne alimentaire et devient libre de créer. Pour rester en haut de cette chaîne alimentaire, l’humain construit des outils qui ont un impact sur le développement de l’humanité. « La main forge l’outil et l’outil change l’homme », résumait ainsi l’ethnologue et historien André Leroi-Gourhan.

a) L’histoire ancienne

L’humain a bien sûr fabriqué des outils pour multiplier la puissance de la force humaine. Dans l’Antiquité, les ingénieuses machines d’Archimède surpassaient tout ce que le muscle humain pouvait accomplir et, en l’an 150 de notre ère, à Alexandrie, une machine à vapeur ouvrait seule la porte d’un temple. Par ailleurs, l’humain a aussi très tôt développé des outils pour se soulager des tâches intellectuelles. Ainsi, la machine d’Anticythère, deux siècles environ avant Jésus-Christ7, permettait de faire des calculs astronomiques sophistiqués, incluant des prédictions d’éclipses, tandis qu’au premier siècle de notre ère Héron d’Alexandrie inventait la première « machine à sous », qui distribuait une quantité précise d’eau bénite lorsqu’on y introduisait une pièce et fonctionnait grâce à une mécanique mue par l’eau selon le principe des boucles de rétroaction. Ces exemples montrent qu’il y a plus de deux mille ans, les principes de l’automatisme et de la systémique, qui sont les bases de l’informatique et de l’intelligence artificielle, étaient non seulement posés, mais donnaient lieu à la fabrication de leurs objets.

Les premiers ordinateurs n’étaient pas si éloignés des machines de l’Antiquité. La grande différence est la capacité de réaliser des opérations logiques intégrant le « et » et le « ou », grâce aux transistors. Ensuite, la miniaturisation a permis d’augmenter le nombre de composants élémentaires par surface, donc de passer à des calculs plus complexes. Si la technologie change, le désir de reproduire, voire de surpasser le raisonnement humain reste une constante dans l’histoire de l’humanité.

b) Des années 1950 à aujourd’hui

En 1952, Alan Turing, l’un des fondateurs de l’informatique, avait déjà réalisé un programme de jeu d’échecs, proche des systèmes experts actuels. Il fallait une demi-heure pour que la machine propose chaque coup. En 1956, le séminaire de Darmouth a réuni pendant dix semaines des scientifiques de très haut rang pour définir l’intelligence artificielle. Parmi eux se trouvaient John McCarthy, Marvin Minsky (cofondateur du laboratoire d’intelligence artificielle au MIT, père des réseaux de neurones), Herbert Simon (prix Nobel d’économie 1978, inventeur de la rationalité limitée) et Claude Shannon (inventeur de la théorie de l’information)8. L’un des objectifs fondamentaux de ce séminaire était de comprendre ce qu’était l’intelligence, au travers d’outils informatiques, avec un autre langage que celui des êtres humains. Il fut la base de nombreux travaux théoriques et pratiques, comme l’invention de langages de programmation orientés vers l’intelligence artificielle.

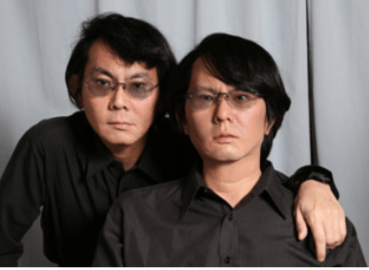

Cette compréhension de l’intelligence que souhaitaient appréhender les participants du séminaire se retrouve dans les mots de Hiroshi Ishiguro (voir photo), l’un des grands chercheurs sur les robots humanoïdes à l’université d’Osaka : « Je construis des robots pour comprendre ce qu’est la conscience9. » D’ailleurs, il est encore plus difficile de définir la conscience quel’intelligence, d’où l’idée intéressante de construire des machines encore plus perfectionnées que les ordinateurs pour interroger la conscience.

Hiroshi Ishiguro et son dual robotique.

Source :

« Hiroshi Ishiguro : Robots like mine will replace pop stars and Hollywood actors », Internationalbusiness, Times, 22nd of March, 2015.

Cité par Dominique Desbois, in « La place de l’a priori dans l’analyse des données économiques ou leprogramme fort des méthodes inductives au service de l’hétérodoxie », Revue Modulad, n° 39, décembre 2008, p.176.

Voir Pedro Domingos, The Master How the quest for the ultimate learning machine will remake our world, Basic Books, 2015.

c) Les différentes écoles du développement de l’intelligence artificielle

L’approche humaine

La première école a tenté d’imiter le raisonnement d’un être humain. Un nouveau métier était né : le cogniticien, dont le rôle consistait à discuter avec un expert de ses méthodes de résolution de problèmes, puis à projeter son expertise dans un langage logique compréhensible par un ordinateur, par exemple, en réalisant des outils d’aide à la décision sous forme de graphiques, d’«arbres de décision ». Cette méthode se heurtait à plusieurs problèmes. D’abord, les experts pouvaient se sentir dépossédés s’ils dévoilaient leur expertise ; le cogniticien devait alors faire tout un travail d’approche psychologique pour ne pas heurter leur sensibilité. Ensuite, les langages informatiques traditionnels étaient procéduraux, et ainsi mal adaptés à une logique de règles. On a donc inventé des langages tels LISP ou Prolog, dont la syntaxe est celle d’un moteurde règles. Ces langages sont aujourd’hui tombés en désuétude. De plus, un moteur de règles n’apparaît pas logiquement rigoureux, en fonction de l’antécédence d’une règle par rapport à une autre. Dans les années 1990, les factures des opérateurs de téléphonie mobile pouvaient varier de quelques pourcents en fonction du chemin emprunté pour calculer le prix, c’est-à-dire de la manière dont le système informatique choisit l’ordre de ses règles de calcul.

L’analyse factorielle et des données

La deuxième école, qui s’est souvent confrontée à la première, utilisait des outils statistiques et, surtout, rejetait tout ce qui était modélisation de l’humain, en d’autres mots, tout ce qui était moteur de règles. La palette des outils était large, allant de méthodes de classification traditionnelles, comme les analyses factorielles, à des modélisations sophistiquées, comme les chaînes de Markov qui ont été longtemps la base des logiciels de dictée automatique. Ce fut l’occasion d’un conflit supplémentaire entre « sciences molles », celles qui privilégiaient une approche plutôt inductive basée sur les modélisations de l’humain, et « sciences dures », qui, à l’inverse, partaient des données et refusaient tout anthropomorphisme. Comme le déclare le statisticien Jean Paul Benzécri, le fondateur de l’analyse des données, « le modèle doit suivre les données, et non l’inverse10 ».

L’imitation de la nature

La troisième école a souhaité modéliser la nature et le cerveau humain. Ce fut le début des réseaux de neurones, une catégorie d’algorithmes utilisant le paradigme du cerveau pour résoudre des problèmes. Les réseaux de neurones sont actuellement dominants dans toutes les applications liées à la reconnaissance des formes : compréhension du langage, traduction automatique, analyse d’image, etc. Ils sont, par exemple, à la base des voitures autonomes.

La recherche d’un algorithme unique

Le professeur Pedro Domingos, de l’université de Washington, va plus loin en partant de cinq formes d’apprentissage : l’inférence humaine fondée sur la philosophie et la logique ; la compréhension du cerveau sur les neurosciences ; la simulation de l’évolution sur la génétique ;l’inférence bayésienne sur les probabilités ; la recherche d’analogies sur l’optimisation mathématique croisée avec la psychologie11. Pedro Domingos énonce que tous ces algorithmes vont finalement converger vers un algorithme unique (« the master algorithm »). Mélanger les chercheurs des sciences dures avec ceux des sciences molles constitue néanmoins un exercice à très haut risque.

Les grandes ruptures de 2011

Yves Caseau et Serge Soudoplatoff, La Blockchain, ou la confiance distribuée, Fondation pour l’innovation politique, juin 2016.

Voir Dave Gershgorn, « The data that transformed AI research–and possibly the world », com, 26 juillet 2017

Aux alentours de 2011, trois grandes ruptures quasi concomitantes ont permis à l’intelligence artificielle de franchir une grande étape :

- tout d’abord, l’introduction d’une catégorie d’algorithmes bien plus sophistiqués : les réseaux de neurones convolutifs ;

- ensuite, l’arrivée sur le marché de processeurs graphiques à bas coût capables d’effectuer d’énormes quantités de calculs ;

- enfin, la disponibilité de très grandes bases de données correctement annotées permettant un apprentissage plus fins.

Les premiers réseaux de neurones modélisaient le comportement des synapses. Ils partaient de données numériques, qui pouvaient être une image, et essayaient de transformer ces données en une information, par exemple « c’est l’image d’un chien », via des algorithmes qui s’inspiraient du fonctionnement des neurones du cerveau. L’apprentissage consistait à calculer les paramètres de ces réseaux de neurones sur des jeux de tests, tels que des couples image-animal. Les neurosciences faisant d’énormes progrès en parallèle, les chercheurs purent améliorer l’architecture de ces réseaux de neurones. Entre autres, l’idée de s’inspirer du cortex visuel a permis de définir une nouvelle classe d’algorithmes, les réseaux de neurones convolutifs. Ce sont ces algorithmes qui sont aujourd’hui utilisés dans les grandes applications de l’intelligence artificielle, comme la reconnaissance de la parole de Siri, la voiture autonome de Google ou bien la reconnaissance d’images de Facebook.

Ces réseaux de neurones ont besoin d’énormes puissances de calcul pour pouvoir fonctionner, tout comme un autre champ d’application, le minage des bitcoins12. La solution pour ce dernier a été d’utiliser les cartes graphiques des ordinateurs, qui devaient créer en temps réel des images animées pour les jeux vidéo. Ces cartes graphiques (en anglais GPU, pour graphics processing unit) ont vu d’un seul coup leurs usages aller bien au-delà de leur premier rôle, permettant d’ailleurs à la société Nvidia, leader sur ce marché, de voir son action en Bourse multipliée par trente en neuf ans.

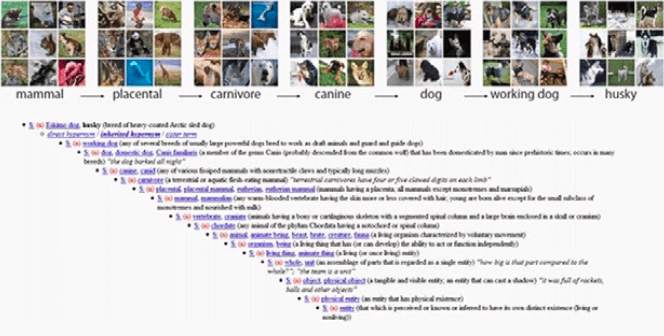

Par ailleurs, tous les statisticiens savent que la qualité et la quantité de données à utiliser pour l’apprentissage sont fondamentales. Plus il y a de données qualifiées, plus l’apprentissage sera fin, et plus l’algorithme sera fiable et précis. L’année 2011 a vu la création d’ImageNet, la première grande base de données d’images annotées13. Créée par Fei-Fei Li, professeure à l’université de l’Illinois, la base atrès vite atteint 1 million d’images annotées selon un arbre sémantique, Wordnet, mis au point en 1980 par George Miller, professeur à Princeton14. À présent, en 2017, ImageNet propose 14 millions d’images indexées selon plus de 21.000 catégories. Il s’agit d’une base de données ouverte et, chaque année, est organisé un concours des meilleurs algorithmes de détection d’éléments dans les images15.

Graphique 1 : Exemple de données de la base ImageNet

Source :

Image extraite du site web de ImageNet.

Ces trois grandes ruptures sont liées. Aucune n’aurait suffi à elle seule pour créer une véritable différence. Ce n’est pas tant la conception d’algorithmes sophistiqués qui a permis à l’intelligence artificielle de se développer – les réseaux de neurones convolutifs sont des versions raffinées mais pas très différentes dans leur esprit de celles développées dans les années 1990 – que la combinaison de ce raffinement algorithmique avec l’augmentation de la puissance de calcul et, surtout, avec la disponibilité de bases de données de plus en plus importantes en taille et en qualité, qui fait qu’aujourd’hui l’intelligence artificielle est capable de réaliser des tâches de plus en plus sophistiquées.

Du big data au data mining

Le big data est la grande rupture de notre époque, qui a permis à l’intelligence artificielle de faire des bonds énormes. Nous sommes dans un monde de production de données en masse. Certaines sont publiques, d’autres sont privées. En 2017, lors d’une seule journée, on a pu observer 96 millions de messages sur Instagram, 200 millions de nouvelles photos et 456 millions de mises à jour de statuts dans Facebook, 645 millions de tweets, 5,5 milliards de requêtes sur Google, 417 milliards de messages sur WhatsApp16.

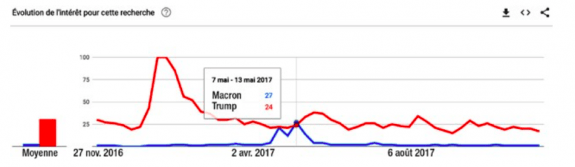

La possession de ces données donne un pouvoir énorme aux GAFA17 et à leurs équivalents chinois. Néanmoins, Google nous offre des interfaces de programmation permettant d’interroger les siennes. Google Maps, par exemple, autorise l’accès à la cartographie de la planète entière. Google propose un site où nous pouvons comparer les tendances sur plusieurs mots- clés, avec possibilité de zoomer sur des zones géographiques, sur des échelles de temps, ou bien de filtrer sur des catégories. À titre d’exemple, nous pouvons ainsi comparer l’évolution de l’intérêt pour la recherche « Macron » versus « Trump » entre novembre 2016 et novembre 2017 (voir graphique 2)18.

La possession de ces données donne un pouvoir énorme aux GAFA17 et à leurs équivalents chinois. Néanmoins, Google nous offre des interfaces de programmation permettant d’interroger les siennes. Google Maps, par exemple, autorise l’accès à la cartographie de la planète entière. Google propose un site où nous pouvons comparer les tendances sur plusieurs mots- clés, avec possibilité de zoomer sur des zones géographiques, sur des échelles de temps, ou bien de filtrer sur des catégories. À titre d’exemple, nous pouvons ainsi comparer l’évolution de l’intérêt pour la recherche « Macron » versus « Trump » entre novembre 2016 et novembre 2017 (voir graphique 2)18.

Graphique 2 : Trump versus Macron dans une requête Google

Google trends : https://trends.google.com/trends/explore?q=Macron,Trump.

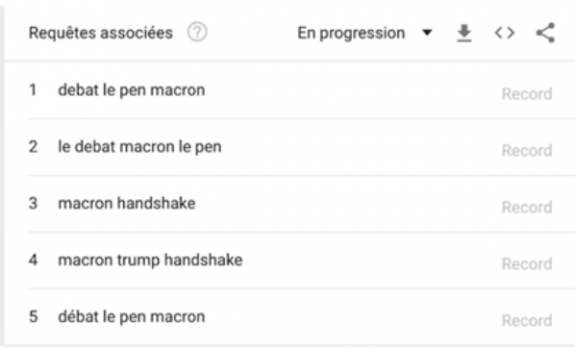

On voit que les recherches « Macron » ont dépassé les recherches « Trump » début mai 2017. Que s’est-il passé à ce moment? Pour le savoir, il suffit de regarder sur la même page du site, un peu plus bas, quelles sont les requêtes associées (voir graphique 3). En position 3 et 4, nous trouvons la fameuse poignée de main entre Emmanuel Macron et Donald Trump qui a enthousiasmé le monde entier ! Nous savions que cette poignée de main était hautement symbolique. Google l’a quantifiée.

Graphique 3 : Requêtes associées

trends.google.com/trends/explore?q=Macron,Trump.

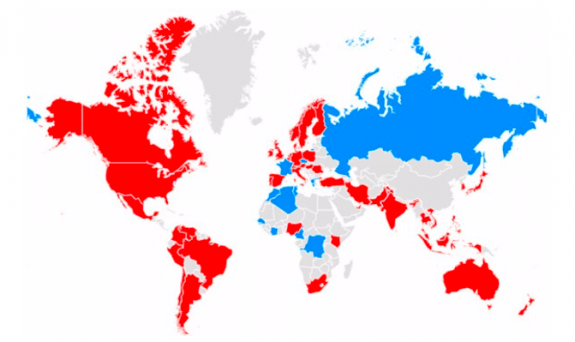

Il est également possible de faire des zooms par région sur la même requête (voir graphique 4). Le président des États-Unis retient l’attention du continent américain, mais en Russie, en France et dans certains pays africains, c’est le président Macron qui l’emporte.

Graphique 4: Requêtes Trump contre Macron selon les pays

https://trends.google.fr/trends/.

Voir Seth Stephens-Davidowitz, Everybody Big Data, New Data, and What the Internet Can Tell Us About Who We ReallyAre, Dey Street Books, 2017.

Voir Andrew Myers, « An artificial intelligence algorithm developed by Stanford researchers can determine a neighborhood’s political leanings by its cars », standford.edu, 28 novembre 2017.

Cette méthode fonctionne pour une pluralité de recherches. Par exemple, la comparaison entre Dementia et Alzheimer a permis de montrer que le premier terme est utilisé dans le monde anglo-saxon, tandis que le second l’est en Europe et en Amérique latine. Cette facilité de faire du zoom in, c’est-à-dire d’aller du général au particulier, est l’un des plus puissants apports du big data. Il existe aussi des jeux de données qui sont publics. ImageNet en est un exemple, mais nous avons aussi la carte du monde entier disponible grâce à OpenStreetMap. Certains sites comme Amazon ou Kaggle19 permettent de savoir quelles sont les données publiques disponibles.

Ces données sont importantes pour la compréhension de notre monde. Le statisticien Seth Stephens-Davidowitz, qui a accès aux données de Google, fait le constat que nous mentons tout le temps : aux sondages d’opinion, à nos amis sur Facebook et dans tous les lieux de partage20. Le seul endroit où nous sommes sincères est lorsque nous posons une question à Google, qui est en quelque sorte devenu le psychanalyste de toute la planète. L’auteur montre ainsi, en analysant les requêtes contenant le mot « nègre », que, contrairement à ce que prétendent nombre de sociologues, l’Amérique est toujours très raciste.

Dans un monde de plus en plus chaotique, les grandes tendances ne suffisent plus. Avant le big data, nous savions que tel État des États-Unis votait plutôt démocrate ou plutôt républicain. Avec le big data, nous pouvons le savoir à l’échelle d’un quartier ou d’une rue. Ce phénomène change radicalement une campagne : les actions à entreprendre pour convaincre les électeurs potentiels sont bien plus ciblées. Ainsi, des chercheurs de Stanford ont réalisé un moteur d’intelligence artificielle qui, en analysant les voitures stationnées sur Google Street View, en déduisent la couleur politique du voisinage21.

Dans les exemples exposés ci-dessus, les données sont essentiellement utilisées pour essayer de comprendre des phénomènes. C’est ce que le monde anglo- saxon appelle le data mining, la capacité d’aller chercher des réponses dans des bases de données de plus en plus riches, croisées avec des outils de plus en plus sophistiqués. Néanmoins, l’humain est encore irremplaçable lorsqu’il s’agit de prendre des décisions à partir des résultats de ces méthodes statistiques. On a vu qu’Emmanuel Macron a devancé Donald Trump en mai 2017 et que la machine peut faire la corrélation entre ce phénomène et l’émergence du mot handshake, mais la mise en contexte politique et l’interprétation de ce que cela signifie pour les relations diplomatiques entre la France et les États-Unis reste encore de l’ordre de la créativité et de l’esprit humain. Le temps n’est pas encore arrivé où, à partir de ces données, un ordinateur en conclurait que le président Macron doit inviter le président Trump au défilé du 14 Juillet de la même année. D’une certaine manière, si le data mining est basé sur des méthodes scientifiques, l’interprétation des données a encore besoin des sciences molles.

En revanche, il est à craindre que les différences d’approches des législateurs sur le problème de la propriété des données engendrent un énorme différentiel dans la disponibilité industrielle d’IA. S’il est raisonnable de vouloir avertir le citoyen de ce que cela signifie d’échanger sur Facebook ou bien de poser des questions à Google, toute contrainte réglementaire sur les données crée néanmoins une problématique. Comme souvent, ceci favorisera les groupes puissants au détriment des start-up. L’IA a besoin de données, espérons que le législateur saura tenir compte de ces aspects avant d’édicter des interdictions.

L’importance e l’apprentissage

Le meilleur moteur d’intelligence artificielle n’est rien sans apprentissage. Investir dans un système d’intelligence artificielle signifie en premier lieu avoir des jeux de données permettant de décrire des cas déjà rencontrés.

Il y a deux grandes catégories d’apprentissage : l’apprentissage supervisé et l’apprentissage non supervisé. Dans le premier cas, l’algorithme est nourri d’exemples : des bases de données annotées lui sont fournies et le système en déduit le programme qui sera utilisé par la suite. Ce programme pourra s’améliorer continuellement si on lui fournit les résultats de ses décisions. Si une image reconnaît un chien alors qu’il s’agissait d’un chat, le fait de lui indiquer que le résultat est mauvais permet d’améliorer l’algorithme. En revanche, dans l’apprentissage non supervisé, on cherche à construire un système qui apprend à partir de rien. Il est possible d’utiliser des méthodes statistiques pour obtenir des séparations automatiques entre plusieurs groupes, par exemple des images de chiens d’un côté et des images de chats d’un autre. Cet apprentissage non supervisé fait actuellement l’objet d’intenses recherches.

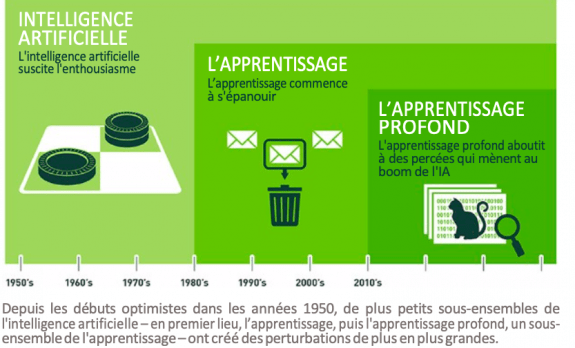

La grande rupture de 2011 a permis l’essor de l’apprentissage profond (deep learning). C’est le début de cette nouvelle classe de réseaux de neurones qui permet de faire des systèmes de reconnaissance d’image, de parole, de vidéo, bien plus puissants que ce qui avait été conçu jusqu’à cette époque, et ce grâce à de gigantesques bases de données.

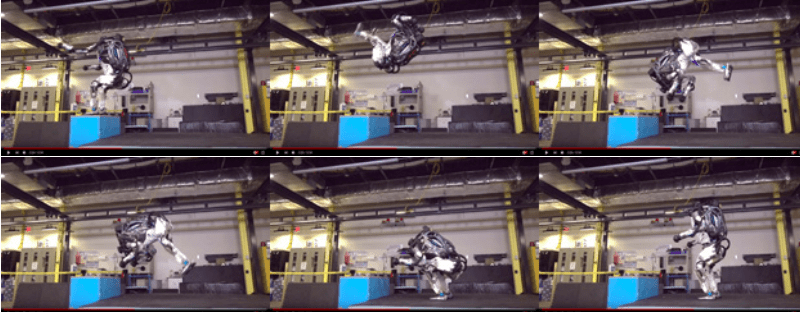

L’Intelligence Artificielle a un autre objectif : nous permettre de résoudre des problèmes ou de prendre des décisions, même au niveau individuel. La voiture autonome possède la carte routière dans sa mémoire, a accès aux informations de trafic. Elle les croise avec les informations qu’elle tire de ses divers capteurs, et doit prendre en permanence des décisions sur la conduite à tenir. Comme le robot qui fait un salto arrière possède des algorithmes neuronaux qui interprètent ses capteurs en permanence, et en déduit les actions à mener sur ses moteurs.

Salto arrière d’un robot

Source :

Pour arriver à ces résultats, l’algorithme a dû passer par une phase d’apprentissage, qui n’est jamais vraiment terminée.

Il y a trois grandes époques de l’intelligence artificielle. Le graphique 5 l’illustre bien : la machine commence à jouer aux échecs, l’apprentissage lui permet de faire la distinction entre spam et courriel normal, et l’apprentissage profond lui permet de dire qu’une image contient un chat.

Graphique 5 : Les trois niveaux de l’intelligence artificielle

Michael Copeland, « What’s the Difference Between Artificial Intelligence, Machine Learning, and Deep Learning? », blogs.nvidia.com/blog/2016/07/29/ whats-difference-artificial-intelligence-machine-learning-deep-learning-ai/.

Il faut néanmoins considérer le fait que l’intelligence artificielle n’est pas que la reconnaissance des formes. À lire le Web, on pourrait penser que les réseaux de neurones sont la solution ultime à tous les problèmes. C’est de fait un excellent paradigme lorsque le contexte est mathématisable. Le robot qui fait un salto arrière, le jeu d’échecs ou la reconnaissance de visage sont des catégories de problèmes scientifiques. Pour l’instant, les sciences dures ont dominé les sciences molles, surtout dans tout ce qui est modélisable rationnellement. La question est finalement de savoir quels sont les domaines de la vie courante qui ne seront jamais mathématisables …

Les grands acteurs de l’intelligence artificielle

Voir Sam Shead, « Facebook is using artificial intelligence to spot suicidal tendencies in its users ».

« Facebook today cannot exist without AI » (Steven Levy, « Inside Facebook’s AI machine », wired.com, 23 septembre 2017.

Voir « Jeopardy, The IBM About IBM Watson Fact Sheet », ibm.com.

Voir « Build on the AI platform business », ibm.com.

Voir « Facebook AI Research (FAIR) », fb.com.

Voir « Caffe2, A new lightweight, modular, and scalable deep learning framework », fb.com.

Voir Raj Reddy, « Foundations and Grand Challenges of Artificial Intelligence », AI Magazine, 9, n° 4, hiver 1988, p. 9-21.

Google, Apple, Facebook et Amazon ne pouvaient pas ne pas s’investir fortement dans l’intelligence artificielle alors qu’ils possèdent des données en énorme quantité. En voici quelques exemples.

a) Google

Google, très impliqué dans l’intelligence artificielle, procède habituellement par rachat. En 2014, Google a acheté la société anglaise DeepMind, qui avait développé des réseaux de neurones pour jouer aux jeux vidéo. Mais l’objectif avoué de DeepMind est actuellement de « comprendre ce qu’est l’intelligence ». DeepMind est célèbre pour son programme AlphaGo, qui a battu le champion du monde de go. En octobre 2017, le programme a franchi une étape supplémentaire : en jouant contre lui-même, non seulement son apprentissage a été plus court, mais surtout il est devenu plus fort que la version précédente22. Nous avons ici un premier exemple d’apprentissage non supervisé, facilité par le fait que le contexte, à savoir les règles du jeu de go, est parfaitement mathématisable. Google a aussi son propre moteur de recommandation nommé Google Home, un haut-parleur et un assistant vocal disponible en trois versions différentes.

b) Amazon

Amazon utilise de l’intelligence artificielle dans son moteur de recommandation, nommé Echo, et dans ses assistants basés sur son système de reconnaissance vocale, Alexa, disponible en sept versions différentes. Via son offre de services dans le cloud, Amazon propose également des services fondés sur l’intelligence artificielle, comme la reconnaissance de la parole ou des robots de discussion, les fameux chatbot23.

c) Facebook

Facebook est un énorme utilisateur d’intelligence artificielle. Il choisit les messages qu’il affiche en utilisant un moteur de type moteur de recommandation. Récemment, Facebook a mis en place un moteur d’intelligence artificielle pour détecter les tendances suicidaires24. Comme le dit Joaquin Candela, directeur du département d’intelligence artificielle appliquée, « Facebook n’existerait pas sans intelligence artificielle25 ».

d) Apple

Apple investit énormément dans l’intelligence artificielle et propose même un blog où sont expliquées ses recherches26. Siri en est l’expression la plus évidente : ce système de reconnaissance de la parole très performant utilise des réseaux de neurones de dernière génération qui permettent de comprendre des commandes même dans des environnements très bruyants, comme dans la rue. Apple va également bientôt lancer son propre moteur de recommandation, nommé HomePod, un haut-parleur connecté avec Apple Music.

e) IBM

IBM a créé Watson, un système d’intelligence artificielle pour jouer, à ses débuts, au jeu Jeopardy, l’équivalent américain de l’émission française Questions pour un champion. Watson a analysé 200 millions de pages27 pour finalement battre les anciens champions et ainsi gagner le premier prix. Maintenant, Watson est proposé par IBM dans d’autres domaines, comme la médecine ou le droit. IBM présente aussi un blog sur le sujet de l’intelligence artificielle28.

La question majeure est le degré d’ouverture de ces systèmes. IBM propose des interfaces de programmation à Watson qui sont ouvertes29, tout comme Amazon propose des interfaces sur son système d’apprentissage profond30. Donc tout le monde peut, à peu de frais, se connecter à ces systèmes et en bénéficier. Facebook, en revanche, ne partage pas la plupart de ses recherches, ne propose pas encore d’interfaces de programmation permettant de les utiliser31, mais a récemment mis en accès libre son environnement d’apprentissage, Caffe232.

Cette apparente simplicité de connexion n’est pas suffisante : il faut insister sur le fait que ce ne sont pas les algorithmes qui détiennent la valeur principale, mais les données d’apprentissage. Ces systèmes d’intelligence artificielle sont d’autant plus performants qu’ils sont contextualisés et ont donc besoin de données ciblées pour profiter d’un apprentissage efficace.

En 1988, le chercheur en informatique indien Raj Reddy définissait ainsi les grands challenges de l’intelligence artificielle : le téléphone qui traduit (en cours de développement), le champion de jeu d’échecs (réalisé), la résolution de théorèmes mathématiques (certains théorèmes le sont déjà), les voitures autonomes (réalisé), les systèmes auto-organisants (en cours) et les systèmes autorépliquants (en cours)33.

L’impact sur les métiers

Voir Richard et Daniel Susskind, The Future of Professions. How technology will transform the work of Human Experts, OxfordUniversity Press, 2015.

Idriss Aberkane, Économie de la connaissance, Fondation pour l’innovation politique, mai 2015.

L’intelligence artificielle est-elle une menace pour les professions, notamment pour les professions intellectuelles ? Une des réponses les plus argumentées a été fournie par Richard et Daniel Susskind34, qui ont analysé l’impact du numérique sur nombre de professions, dont celles de médecins, avocat, enseignant, architecte, comptable, et même celles du clergé. Six menaces semblent peser sur les professions intellectuelles :

- la première est économique : les prix des experts sont très élevés et sont donc inaccessibles au plus grand nombre ;

- la deuxième est technologique : les professions reposent encore sur des méthodes et des outils du passé, et n’utilisent pas assez les technologies modernes ;

- la troisième est psychologique : les professionnels n’autorisent pas assez l’auto résolution des problèmes par les clients eux-mêmes, en refusant de partager leur savoir ;

- la quatrième est d’ordre moral et est une conséquence des menaces précédentes : les professionnels, indispensables à la société et pourtant inaccessibles, voient leur image se dégrader ;

- la cinquième est qualitative : la qualité des services n’est plus au rendez- vous, excepté parmi la classe supérieure des quelques experts mondialement reconnus ;

- la sixième menace est l’opacité des professionnels, qui refusent souvent d’être évalués et préfèrent entretenir une couche de mystère autour de leurs réelles compétences.

Ce sévère constat explique pourquoi l’intelligence artificielle représente un véritable challenge pour les professionnels. Les systèmes d’intelligence artificielle apportent des solutions à chacun de ces problèmes. Ils sont de moins en moins chers, à la pointe de la technologie ; de plus en plus accessibles, ils autorisent l’apprentissage, ils sont plus performants que beaucoup d’experts et ils peuvent être transparents.

Comme l’analyse Idriss Aberkane, nous résoudrons les graves problèmes qui pèsent sur notre planète par le développement de l’économie de la connaissance35. Or celle-ci ne peut pas fonctionner si la connaissance reste une rareté. Le grand challenge des «cols blancs» d’aujourd’hui est de passer à une économie d’abondance pour ce qui concerne l’expertise. C’est justement ce que l’intelligence artificielle est en train de permettre. Il ne reste plus aux professionnels qu’à entreprendre le douloureux travail de remise en cause de leurs processus et de leurs méthodes pour tirer parti de la technologie. Ce ne sera pas la première fois dans l’histoire de l’humanité.

La médecine

La médecine française est basée sur une tradition hippocratique de soins a posteriori. La prévention n’est pas dans les gènes de l’école de médecine. Or c’est justement dans le domaine de la prévision que les plus grands progrès ont été effectués grâce à l’intelligence artificielle, avec surtout une grande disruption, les techniques génomiques.

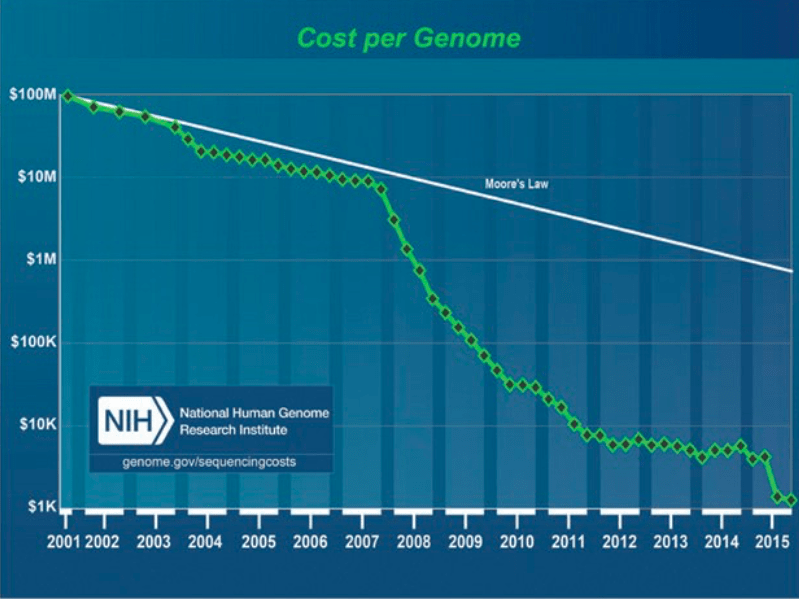

Le séquençage génomique a vu son coût passer de 100 millions de dollars à moins de 100 dollars entre 2001 et 2017 (voir graphique 6). C’est beaucoup mieux que la loi de Moore sur les microprocesseurs.

Graphique 6 : Evolution du coût du séquençage génomique

Source :

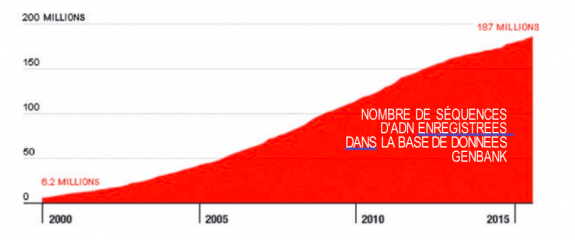

Aux États-Unis, la société 23andMe propose votre séquençage ADN pour la modique somme de 99 dollars si vous souhaitez juste savoir qui sont vos ancêtres, et de 199 dollars si vous voulez savoir quelles sont les maladies génétiques dont vous êtes porteur36. Ce séquençage génétique devient surtout utile lorsqu’il est croisé avec des bases de données. C’est donc, une fois de plus, dans la constitution de ces bases et leur interprétation par des moteurs d’intelligence artificielle que se situe la valeur. La plus grande base est Genbank, qui contient près de 200 millions de séquences ADN en accès libre (voir graphique 7).

Graphique 7 : Evolution du nombre de données de séquences d’ADN

National Center for Biotechnology Information.

Voir Greg Ip, « How Robots May Make Radiologists’ Jobs Easier, Not Redundant », The Wall Street Journal, 22 novembre 2017.

Nicolas Bouzou et Christophe Marques, Hôpital : libérer l’innovation, Fondation pour l’innovation politique, février 2017.

Voir « Pourquoi la moitié des hôpitaux vont adopter l’intelligence artificielle d’ici 5 ans », lespécialiste.be, 18 juillet 2017.

Le lecteur souhaitant approfondir l’impact de l’intelligence artificielle sur la médecine et sur d’autres métiers pourra trouver matière dans les analyses d’Olivier Ezratty présentant une documentation approfondie sur l’intelligence artificielle en 2017 (voir notamment Olivier, Ezratty, « Les usages de l’intelligence artificielle », oezratty.net, 19 octobre 2017).

Mais il n’y a pas que la génétique qui est bouleversée par l’intelligence artificielle et le big data. L’exemple des radiologues est illustratif. Aux États-Unis, il y a chaque année environ 800 millions d’examens radiologiques effectués, générant 60 milliards d’images37, soit une énorme banque d’informations permettant de faire des diagnostics plus précis. IBM Watson, entre autres, a su ainsi mieux que des médecins détecter des cas de pneumonie.

Et l’on pourrait multiplier les exemples à l’infini. Les systèmes d’intelligence artificielle dans le monde médical ont accès à des millions de dossiers médicaux et permettent des diagnostics bien plus individualisés que ce qu’un médecin peut faire. Aucun médecin, généraliste ou spécialiste, ne serait en mesure d’ingurgiter un tel nombre de données.

Pour le cas français, l’intelligence artificielle aura du mal à pénétrer les hôpitaux, peu sensibles au numérique au sens traditionnel comme l’ont déjà souligné Nicolas Bouzou et Christophe Marques38. Et si le numérique est en retard dans les hôpitaux, alors quid de l’IA [intelligence artificielle] ! Si le lecteur tape “intelligence artificielle et hôpitaux” sur Google, il verra plein de têtes de chapitres enthousiastes décrivant comment l’IA va améliorer l’hôpital, mais il va vite se rendre compte que ces articles sont suisses ou belges39 ».

Le futur

Voir « The quest of AI creativity », ibm.com.

Melba Kurman, « The coming creativity explosion belongs to the machines », singularityhub, 1er octobre 2017.

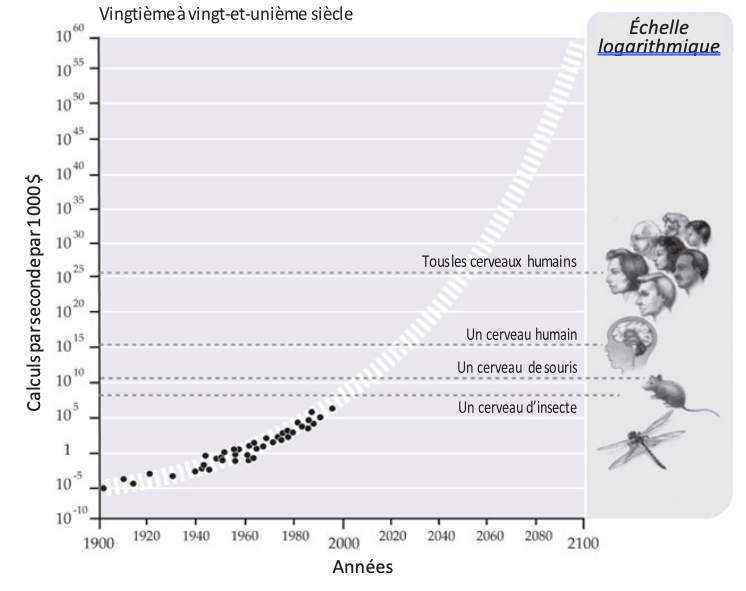

Une question souvent entendue est la suivante : que reste-t-il à l’humain que la machine ne sache pas faire ? L’intuition ? Mais l’intuition n’est-elle pas la qualité indispensable surtout lorsque l’on manque de données ? L’empathie ? Mais l’informatique affective est un des grands sujets de recherche actuellement ; par exemple, le Massachusetts Institute of Technology (MIT) a consacré à ce thème un département entier, sous la direction de Rosalind Picard40. La créativité ? C’est aussi un sujet d’exploration de IBM Watson41 qui, à la mi-2016, a créé une bande-annonce pour un film d’horreur. Dans un article datant d’octobre 2017, Melba Kurman avance l’idée que ce n’est pas la créativité qui nous distinguera de l’intelligence artificielle, elle-même devenue créative, mais plutôt notre capacité à piloter la créativité des machines42. Cet article permet d’ailleurs d’aborder le grand débat actuel : la singularité. Ce concept, inventé par Ray Kurzweil, part du constat que si l’on poursuit la courbe d’augmentation de la puissance des ordinateurs, vers 2020 nous aurons la capacité de traitement du cerveau humain, et vers 2060 celle de toute l’humanité. De plus, des technologies basées sur la mécanique quantique et non sur l’électronique ouvriraient la voie à des puissances de calcul qui seraient plus proches de l’exponentiel que du polynomial, ce que sont les ordinateurs actuels. La courbe en serait encore plus vertigineuse (voir graphique 8).

Graphique 8 : croissance exponentielle de la puissance de calcul

Source :

« Comment le futur de l’intelligence artificielle pourrait révolutionner le monde d’ici 25 ans », Huffingtonpost, Gregory Rozières, 5 octobre 2016.

Jean-Gabriel Ganascia, Le Mythe de la singularité. Faut-il craindre l’intelligence artificielle ?, Seuil, 2017.

Voir Julien Lausson, « Ekso, l’exosquelette qui veut rendre le fauteuil roulant obsolète », com, 16 novembre 2015.

À ce stade, il est intéressant de faire remarquer qu’il semble normal de mener des recherches sur l’humain augmenté, mais anormal d’utiliser des dopants dans le Tour de Pourtant, les 24 Heures du Mans ont été conçus dans l’idée de tester la machine en la poussant à ses extrêmes. L’esprit humain peut donc ainsi être contradictoire et largement sous-optimal.

Pour un ordinateur d’une valeur de 1000 dollars constants, on obtient une intelligence artificielle qui atteint le niveau de l’intelligence d’un humain en 2020.

La singularité engendrera une rupture dans l’évolution de l’être humain. Certains parlent même d’un remplacement des humains par la machine. Les robots humanoïdes seraient alors les représentants de l’armée de demain, qui éradiquerait l’humanité et prendrait sa place. Ce phénomène est connu : plus un robot ressemble à un être humain, plus il engendre de l’inconfort. On parle alors de « vallée dérangeante » (uncanny valley). Les réalisateurs de films pour enfants le savent bien : les monstres ne doivent surtout pas ressembler à un individu ordinaire.

Ce qui nous protège de notre disparition au profit de la machine est lié à la grande découverte de Pasteur : les molécules du vivant sont asymétriques. L’être humain est le résultat d’environ 1,5 milliard d’évolutions biologiques. Petit à petit, un ADN, de plus en plus complexe, s’est construit au fil de nombreux essais et de nombreuses erreurs. Si, dans un futur de science-fiction délirant, les robots prenaient la main à la manière de HAL dans le film 2001, l’Odyssée de l’espace, de Stanley Kubrick, leur premier problème serait d’éradiquer tout ce qui est biologique, depuis les humains jusqu’aux protozoaires et aux acides aminés. Si les Japonais vénèrent ainsi le gingko bilboa, c’est parce que cet arbre fut la première manifestation de la force vitale l’ayant fait repousser à Hiroshima quelques mois seulement après l’explosion de la bombe atomique. Ce n’est pas un bouleversement technologique qui pourrait éventuellement nous faire disparaître, mais un changement radical de contexte, tel le réchauffement climatique. Il est plutôt rassurant de voir actuellement le nombre de chercheurs et de jeunes entreprises qui se penchent sur le problème de l’environnement, en utilisant justement les outils de l’intelligence artificielle. Comme le souligne Jean-Gabriel Ganascia, les théories de la singularité sont, sous uncouvert rationnel, finalement assez irrationnelles, et ressemblent plus à des gnoses modernes qu’àdes réflexions scientifiques argumentées43.

En revanche, c’est dans le transhumanisme, surtout dans sa dimension de coopération entre la mécanique et la biologie, que se trouve un gisement énorme de découvertes scientifiques. Les exosquelettes qui sont utilisés pour aider des paraplégiques à remarcher sont d’extraordinaires combinaisons de mécanique de précision et d’algorithmes très puissants44. Nous parlons alors d’humain augmenté, à l’aide de technologies informatiques, mécaniques, et biochimiques45. La combinaison des biotechnologies, de l’intelligence artificielle et des nanotechnologies ouvre la porte à bien des découvertes potentielles. Bien que ce ne soit pas le sujet ici, on peut ainsi se poser la question de l’impact sur une possible mutation de l’humain de l’extraordinaire découverte, par Jennifer Doudna et Emmanuelle Charpentier, des « ciseaux génétiques » CRISPR-Cas9 capables de couper l’ADN à volonté46.

Conclusion

Voir « Robot Sophia speaks at Saudi Arabia’s Future Investment Initiative », vidéo de la chaîne Arab News, com, ocyobre 2017.

Voir « The robot running for NZ Prime Minister in 2020 », co.nz, 27 novembre 2017.

Voir Pierre Pezziardi, Serge Soudoplatoff et Xavier Quérat-Hément, Pour la croissance, la débureaucratisation par la confiance, Fondation pour l’innovation politique, novembre 2013.

Il est bien difficile de tirer des conclusions lorsque l’on se trouve au début d’une histoire. En effet, l’intelligence artificielle n’en est qu’à ses balbutiements et la difficulté de cette note est qu’entre le moment de son écriture, de sa publication et de sa lecture, beaucoup de découvertes auront été réalisées, beaucoup de décisions prises et beaucoup de communiqués publiés.

Ainsi, à la fin de l’année 2017, deux annonces ont fait sensation : l’Arabie saoudite a accordé la nationalité saoudienne à un robot47 et la Nouvelle- Zélande a annoncé qu’elle présentera un robot au parlement en 202048. Nos politiques seraient-ils « robotisables » ? La tentation de certains est d’en affirmer la possibilité afin de réduire l’irrationalité et l’incertitude inhérente à l’être humain dans le cadre des institutions politiques. Mais cette intelligence artificielle, basée sur des algorithmes, ne fonctionnera que si le contexte est mathématisé. De même que mathématiser les règles du jeu de go est facile, mathématiser certaines parties de l’administration publique est un jeu d’enfant, et c’est d’ailleurs parce que la bureaucratie le sait qu’elle est très peu désireuse de se numériser49. Mais mathématiser l’Assemblée nationale ne l’est pas. La véritable question est de savoir si mathématiser la politique présente un quelconque intérêt pour le bien des peuples, autrement dit de savoir si on améliorerait le système actuel, en effet largement sous-optimal.

Pour calmer les enthousiastes de la disruption totale, il faut souligner que l’être humain a toujours de l’avance sur la machine. Le monde est de plus en plus complexe, et si de plus en plus de tâches humaines peuvent être réalisées par de l’intelligence artificielle, les esprits curieux et aventuriers y trouveront des opportunités de progrès extraordinaires afin de faire « mieux avec » plutôt que «contre», et de rester toujours indispensables.

Pour aiguillonner les décideurs, il faut leur dire que c’est le moment d’oser. Les compétences sont présentes, certains systèmes sont ouverts. Il faut expérimenter et, surtout, créer des données même si les usages ne sont pas encore présents, car c’est là que se trouve la valeur. Nous sommes dans un monde où la connaissance joue un rôle fondamental. C’est la connaissance partagée qui va résoudre les problèmes de la planète, et il faut agir vite. Ce n’est pas un hasard si l’intelligence artificielle est devenue essentielle, car elle seule permet cette disponibilité étendue de la connaissance, contrairement au goulet d’étranglement qui préserve une forme de rareté de l’expertise.

Dans notre vaisseau spatial de plus de 7 milliards d’astronautes où les interactions sont perpétuelles, dans ce monde hypercomplexe, tout ce qui est de l’ordre du linéaire prédictif est inopérant. Il est inutile de faire des plans à cinq ans quand on ne sait pas quelle sera la température la semaine prochaine. Pour paraphraser Bertrand Russell, « tous les matins, l’oie du Périgord est deux fois plus heureuse que la veille… jusqu’au 23 décembre ». Ce qu’il faut viser, en revanche, c’est l’homéostasie, autrement dit la capacité à rester en équilibre dynamique, indépendamment des variations de l’environnement. Le numérique n’est pas la cause mais la solution. Pour maintenir cette homéostasie, nous avons besoin d’outils permettant de prendre des décisions efficaces, rapides, argumentées, donc basées sur des données, du savoir, de la connaissance. Nous avons besoin de l’intelligence artificielle.

Nous sommes au début d’une gigantesque et passionnante aventure. Ce n’est pas dans les astres qu’il faut chercher le futur, mais dans la tête de ceux qui le construisent.

Aucun commentaire.